- 2026/02/12 掲載

松尾研が整理する生成AIガバナンス、AIに任せていい判断、ダメな判断の「境界線」

東京大学工学部卒、同大学院工学系研究科技術経営戦略学専攻修了。2020年より、松尾研究所に参画し、機械学習の社会実装プロジェクトの企画からPoC、開発を一貫して担当。その後、社内外の特命プロジェクトを推進する経営戦略本部を立ち上げ・統括。また、AI・知能化技術の応用により成長の見込めるベンチャー企業への投資に特化したVCファンドを新設し、代表取締役を務める。松尾研究所の参画以前は、シティグループ証券株式会社にて、日本国債・金利デリバティブのトレーディング業務に従事。

AIは信用できる相棒か、それとも事故要因か?

ChatGPTに代表される生成AIは、文章作成や要約、コード生成などを高速にこなす「万能で知的なバディ」として急速に普及した。多くの企業がすでに業務利用を始めており、生産性向上や新サービス創出への期待は大きい(注1)。一方、誤情報の生成(ハルシネーション)、バイアスを含んだ判断、想定外の情報流出など、AIを本当に信用して良いのか不安となる問題も顕在化している。こうした期待と不安が交錯する中で、生成AIを「信用できるバディ」として業務に組み込むための、具体的なガバナンス設計が求められている。

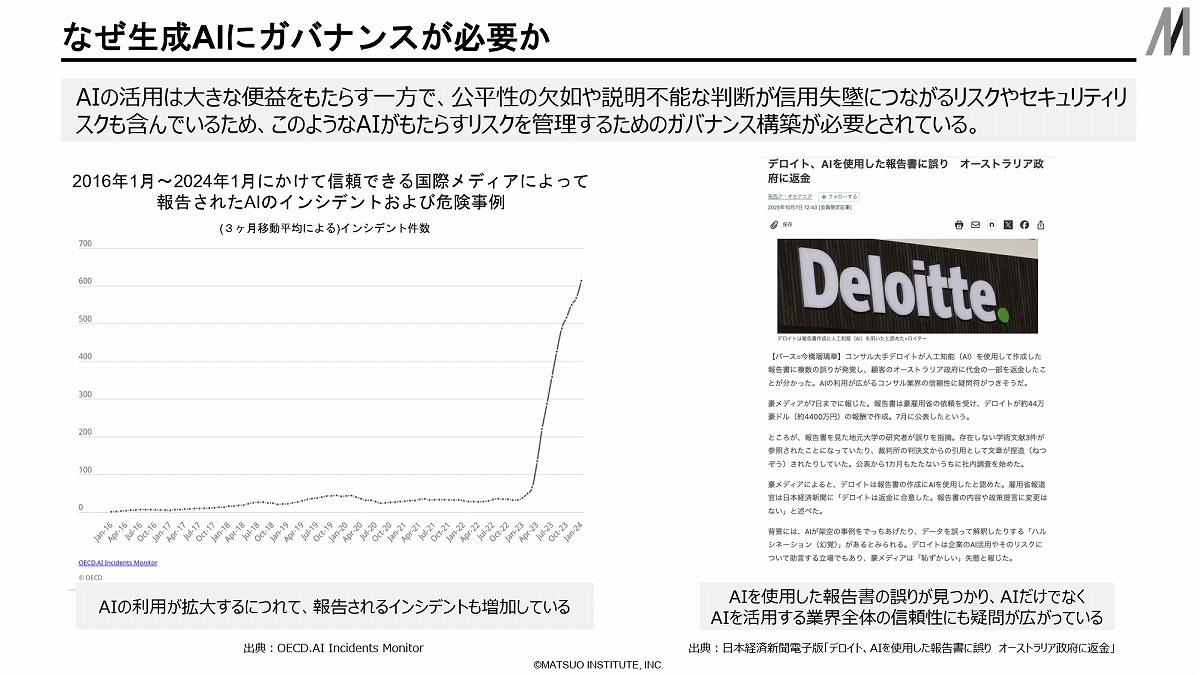

金融庁は論点整理のなかで、AIの活用は大きな便益をもたらす一方で、公平性の欠如や説明不能な判断が信用失墜につながり得るとし、「リスクを管理するためのガバナンス態勢の構築」が不可欠だと指摘している(注2)。

AIの判断が誤った場合、その影響は一企業の損失にとどまらず、社会インフラ全体の信頼を揺るがす可能性がある。

だからこそ、「便利だから使う」のではなく、「どの範囲で、どのレベルのリスクを許容するか」を経営レベルで設計しなければならない。

国際的にも、OECDのAI原則(注4)など、AIを人権や民主主義にも関わる社会システムとして扱う枠組みづくりが進んでいる。

日本ではIPAがテキスト生成AIガイドラインを公開し(注1)、金融庁もAIディスカッションペーパーを通じて、金融機関におけるAI活用とガバナンスの論点を整理している(注3)。

生成AIガバナンスは、規制・監督当局を含めた社会全体のテーマになっている。企業が整備すべきポイントは3つに整理できる。

第1に、経営層がリスクと機会の両面を把握し、責任の所在を明確にした体制を構築すること。

第2に、モデル選定からデータ取り扱い、利用目的の定義、ログ管理、第三者評価に至るまで、サイクル全体をカバーするルールとプロセスを準備すること(注5)。

第3に、現場の利用者任せにせず、教育とガイドラインを通じて「人間側のリテラシー」を高めることである。 【次ページ】ハルシネーション、漏えい、バイアス──生成AIが“静かに事故る”理由

AI・生成AIのおすすめコンテンツ

AI・生成AIの関連コンテンツ

PR

PR

PR