- 会員限定

- 2025/05/22 掲載

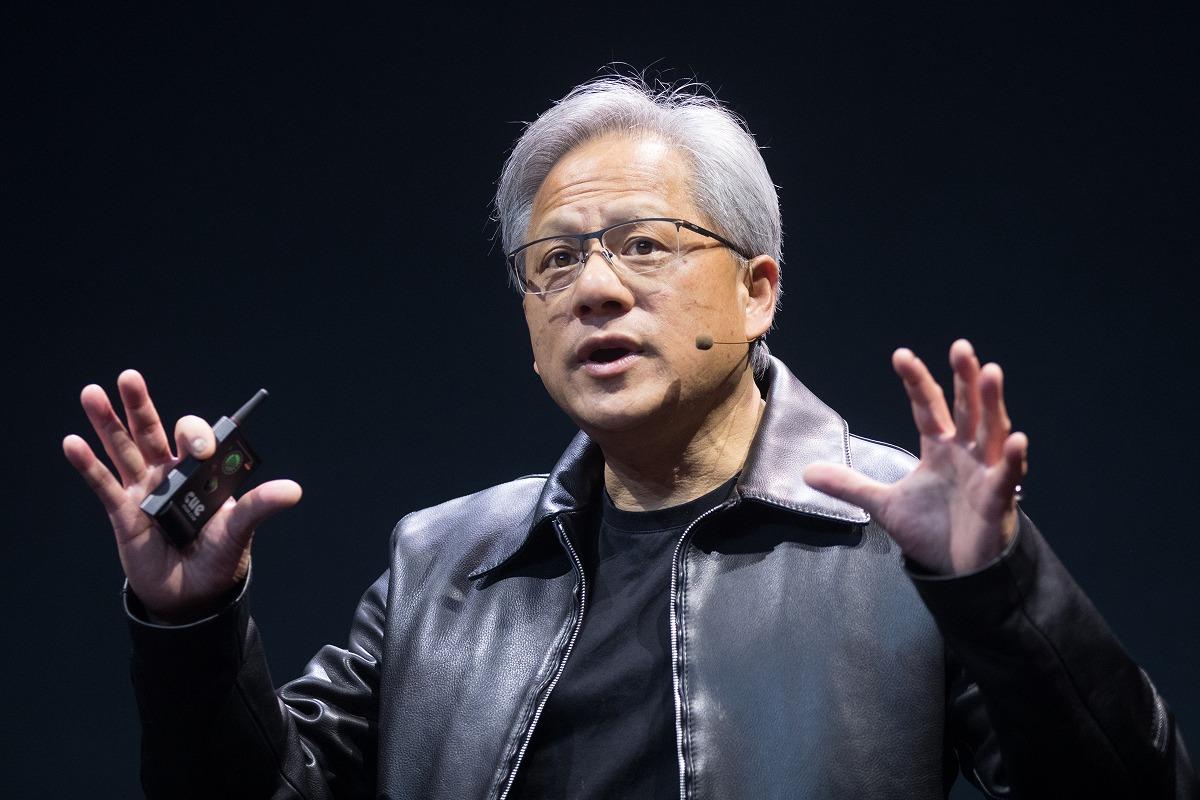

NVIDIA最大イベントでジェンスン・フアンCEOが語った「重要すぎる戦略転換」

バークリー音大提携校で2年間ジャズ/音楽理論を学ぶ。その後、通訳・翻訳者を経て24歳で大学入学。学部では国際関係、修士では英大学院で経済・政治・哲学を専攻。国内コンサルティング会社、シンガポールの日系通信社を経てLivit参画。興味分野は、メディアテクノロジーの進化と社会変化。2014〜15年頃テックメディアの立ち上げにあたり、ドローンの可能性を模索。ドローンレース・ドバイ世界大会に選手として出場。現在、音楽制作ソフト、3Dソフト、ゲームエンジンを活用した「リアルタイム・プロダクション」の実験的取り組みでVRコンテンツを制作、英語圏の視聴者向けに配信。YouTubeではVR動画単体で再生150万回以上を達成。最近購入したSony a7s3を活用した映像制作も実施中。

http://livit.media/

オープンソースによるエコシステム構築

2025年3月17 021日、NVIDIAの年次カンファレンス「GTC」が開催された。同社のジェンスン・フアンCEOが明らかにしたのは、エージェンティックAIとロボット分野を軸に、AI半導体/インフラ需要を押し上げつつ、総合的なAIプラットフォーマーとしてのポジションを確立する新戦略だ。エージェンティックAI分野では、オープンソースモデルとソフトウェアの提供によるエコシステム拡大を狙う。

具体的な取り組みの1つが、AIモデルの推論処理を最適化するオープンソースソフトウェア「Dynamo」の公開だ。これは複数のGPUを使って行われる推論処理(AIモデルが回答を生成する処理)を最適化するソフトウェア。

たとえば、ユーザーからの質問に対する「理解」と「回答生成」という異なる処理を、それぞれ別のGPUに振り分けて最適化。さらに、過去の質問に関する知識をGPUのメモリに保持し、類似の質問が来た際に再計算を避けることで、処理効率を大幅に向上させる仕組みを備えている。AI検索のPerplexityは、Dynamoを活用した取り組みを進めているという。

フアンCEOはDynamoに関して、「産業界は異なる方法でAIモデルを考え、学習させることで、時間とともにより洗練されたものへと進化させている。カスタマイズされた推論AIの未来を実現するため、NVIDIAのDynamoはこれらのモデルをスケールさせながら、AIファクトリーのコスト削減と効率化を支援する」と説明した。

同社はまた、メタのオープンソースモデル「Llama」をベースに、推論機能を強化した「Llama Nemotron」シリーズを発表。同シリーズは、エッジ向けの「Nemotron Nano」、単一GPUデータセンター向けの「Nemotron Super」、マルチGPUデータセンター向けの「Nemotron Ultra」の3モデルで構成される。Anthropicの最新モデルClaude 3.7と同様に、推論モードをオン・オフできる機能を備えており、クエリの処理負荷を最適化することが可能だ。

これらのオープンソース戦略には、Together AIやCohere、Perplexityといった企業が賛同を表明。Together AIのチェ・ジャン最高技術責任者は、「推論モデルを効率的にスケールさせるには、分散サービングやコンテキストを意識したルーティングなど、高度な推論技術が必要となる。NVIDIAのDynamoのオープン性とモジュール性により、我々のエンジンにシームレスに統合でき、リソース利用を最適化しながら、より多くのリクエストに対応できるようになる」と評価している。

このように同社は、推論モデルとエージェンティックAIの普及を見据え、オープンソース戦略を通じてエコシステムの拡大を推進。これにより、自社のハードウェア需要の底上げを図る構えだ。

2つの需要を取り込むハードウェア戦略

NVIDIAは、オープンソース戦略と並行して、推論モデルとエージェンティックAIの普及を見据えたハードウェアの強化も進めている。その中核となるのが、次世代AI処理基盤「Blackwell Ultra」プラットフォームだ。同プラットフォームの特徴は、推論モデルやAIエージェントシステムの処理に最適化された設計にある。72台のBlackwell Ultra GPUと36台のArmベースのGrace CPUをラックスケールで接続した「GB300 NVL72」を提供。複雑な課題を複数のステップに分解し、異なる解決策を探る推論モデルの処理に対応する。

また16台構成の「HGX B300 NVL16」では、前世代のHopperと比較して、大規模言語モデルの推論速度を11倍、計算能力を7倍、メモリを4倍に向上させた。

こうした性能の大幅アップは、処理トークン数が何十倍にも増える推論モデルやエージェンティックAIの普及に不可欠なもの。

GTCでは、このことを示すデモが披露された。

このデモでは、従来型モデルとなるメタのLlamaモデルと、推論モデルとなるDeepSeekのR1に対し、結婚式での7人掛けテーブルの座席配置という課題が与えられ、回答精度と処理トークン数の比較が実施された。新郎・新婦の両親を隣り合わせにしないなどの制約条件付きの複雑な課題だ。

メタのLlamaは、即座に439トークン(約329ワード)の回答を生成したものの、その内容は誤りを含んでいた。一方、DeepSeek R1は制約条件を一つずつ検証しながら慎重に推論を重ね、すべての条件を満たす正確な座席配置を導き出すことに成功した。しかし、そのトークン数は、Llamaの20倍近い8559トークンに及んだ。

こうした推論モデルは、さまざまなエージェントシステムに組み込まれており、クエリ次第では処理トークン数は、何百倍にも膨れ上がる可能性もある。たとえば、史上最速で年間経常収益1億ドルを達成したと言われるコーディングアシスタントCursorでは、OpenAIのo3-miniやDeepSeekのR1などが利用可能だ。

フアンCEOは、推論モデルやエージェントシステムの応答時間を、既存モデルと同等に速さに維持するには10倍早く処理する必要があり、最終的に処理するデータ量は少なくとも100倍にはなるだろうと指摘している。

Blackwellは、こうしたニーズに対応できるように設計されており、テック企業/AI企業からの注目度は高い。実際、Blackwell GPUの初年度出荷数は360万台に達する見込みで、前世代「Hopper」の最盛期における主要クラウド4社(AWS、マイクロソフト、グーグル、オラクル)向け出荷数130万台を大きく上回る規模となる。 【次ページ】ロボティクス分野でも取り組み加速

半導体のおすすめコンテンツ

PR

PR

PR