- 2022/05/19 掲載

Citadel AIとグルーヴノーツ、「Citadel Lens」と「MAGELLAN BLOCKS」が連携

国内全体で、AIを実利用する企業は半数以上と年々増加しています(*1)。AIシステムを中長期的に運用していくには、AIモデルの構築・運用後の再学習などライフサイクルを通じて、AIを継続的に評価モニタリングし、AI特有の品質リスク管理を行うことが重要になってきます。

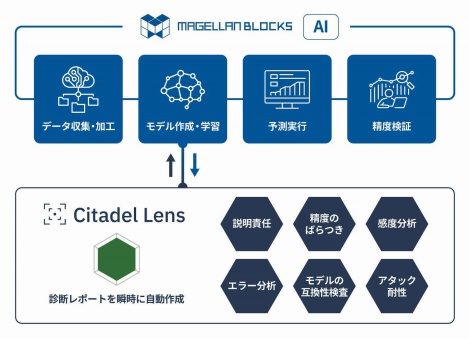

Citadel AIが提供する「Citadel Lens」は、AIモデルの学習時におけるAI品質評価ツールです。AIの信頼性や説明責任問題(*2)に関わる、精度のばらつき(*3)・バージョン間の互換性(*4)・アタックに対する耐性(*5)等を自動テストし「点数化」します。また、AI品質モニタリングツールである「Citadel Radar(シタデル・レーダー)」は、運用段階において、AIモデルへの入出力の異常をリアルタイムに自動検知・防御してAIのブラックボックス化の解消を図ります。

グルーヴノーツの「MAGELLAN BLOCKS」AIサービスは、数値・画像・文字などのさまざまなAI技術を手軽に活用できるクラウドサービスです。プログラミングを必要とせず、容易な操作でデータ加工・AIモデル作成・予測・評価のステップを実践でき、多くのユーザーが利用しています。

このたびの「MAGELLAN BLOCKS」AIサービスと「Citadel Lens」の連携により、ユーザー自身がAIの品質をわかりやすく客観的に把握できるようになります。「説明可能なAI」としてAIへの信頼性や透明性を高め、AI活用の定着を促進します。今後さらに「Citadel Radar」との連携を検討するなど、両者ともにAIの普及・促進に向けたソリューションの提供に努めてまいります。

(*1)IT専門調査会社 IDC Japan株式会社「2022年 国内AIシステム/データアナリティクス市場 企業ユーザー調査」https://www.idc.com/getdoc.jsp?containerId=prJPJ49020822

(*2)AIに与えるデータの偏り、AIを適用するビジネス領域や外部環境の変化等により不適切な出力結果を出す可能性、また、外部からのアタック等により誤認識や誤学習が発生してしまう可能性など、AIを活用する上で配慮すべきAI固有の問題。AIの信頼性や説明責任に関して、EUでは規制案が示されたほか、日本企業各社ではガイドライン策定が進むなど、世界的に関心が高い。

(*3)英語で「Model bias(モデルバイアス)」のことを指し、精度の良い領域と悪い領域が混在している状態のこと。ある特定の顧客層等に対して、未学習状態が残っていること等によって発生する。

(*4)英語で「Backward compatibility(バックワードコンパチビリティ)」のことを指す。AIモデルの改修や新しいデータを使った再学習等によってできる新しいバージョンのモデルが、従来のバージョンと齟齬のない予測結果を出している状態のこと。

(*5)英語で「Adversarial robustness(アドバサリアルロバストネス)」のことを指す。AIを騙すようなデータを入力されるなど、誤認識や誤学習を狙った外部からの攻撃に対する耐性のこと。

プレスリリースのおすすめコンテンツ

PR

PR

PR