- 2025/12/15 掲載

Google、AIに人間のような「長期記憶」を持たせる新アーキテクチャ「Titans」とフレームワーク「MIRAS」を発表

従来のTransformerの限界を克服、極めて長い文脈処理や、過去の情報を持続的に保持・更新できるアーキテクチャ

現在のTransformerモデルは注意機構を用いることで短期的には高い文脈把握能力を発揮するものの、シーケンスが長くなるほど計算コストが二次関数的に増加し、大規模文書や長時間の対話履歴を一貫して扱うには限界がある。このため長期記憶保持は長年AI研究の課題となってきた。

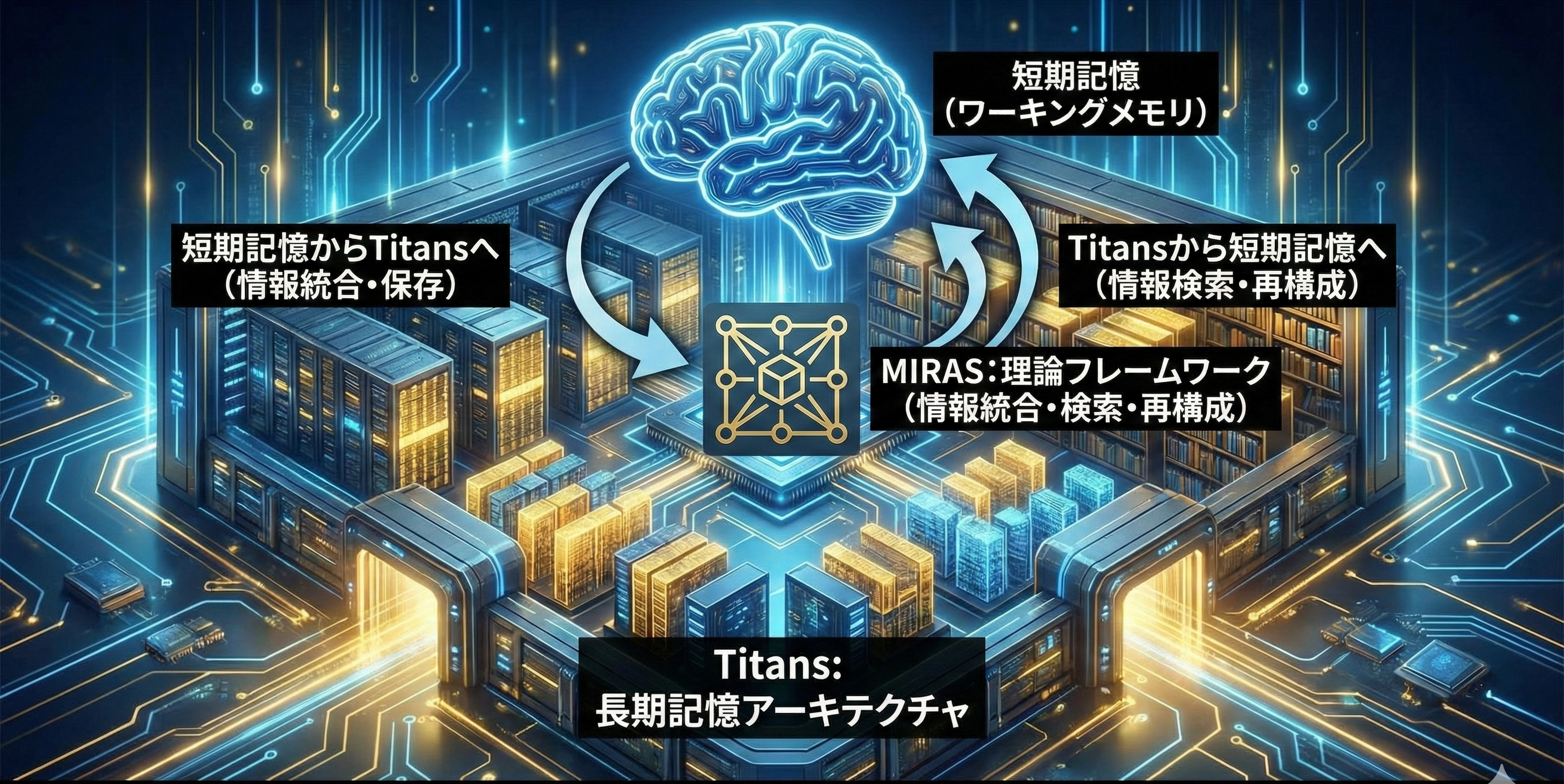

Titansはこの課題に対し、モデル実行中にコアの長期メモリをリアルタイムで更新する能力を導入したアーキテクチャである。このメモリモジュールは単なる固定ベクトル・行列ではなく、多層パーセプトロンに基づくニューラル長期記憶機構として機能する。

モデルは新情報の「サプライズ」(予想外性)を計算し、重要と判断した情報を選択的に記憶し、不要な部分は適応的に忘却する仕組みを備える。これにより、単一モデルが数百万トークン以上に及ぶ長いコンテキストを効率的に扱うことが可能になる。

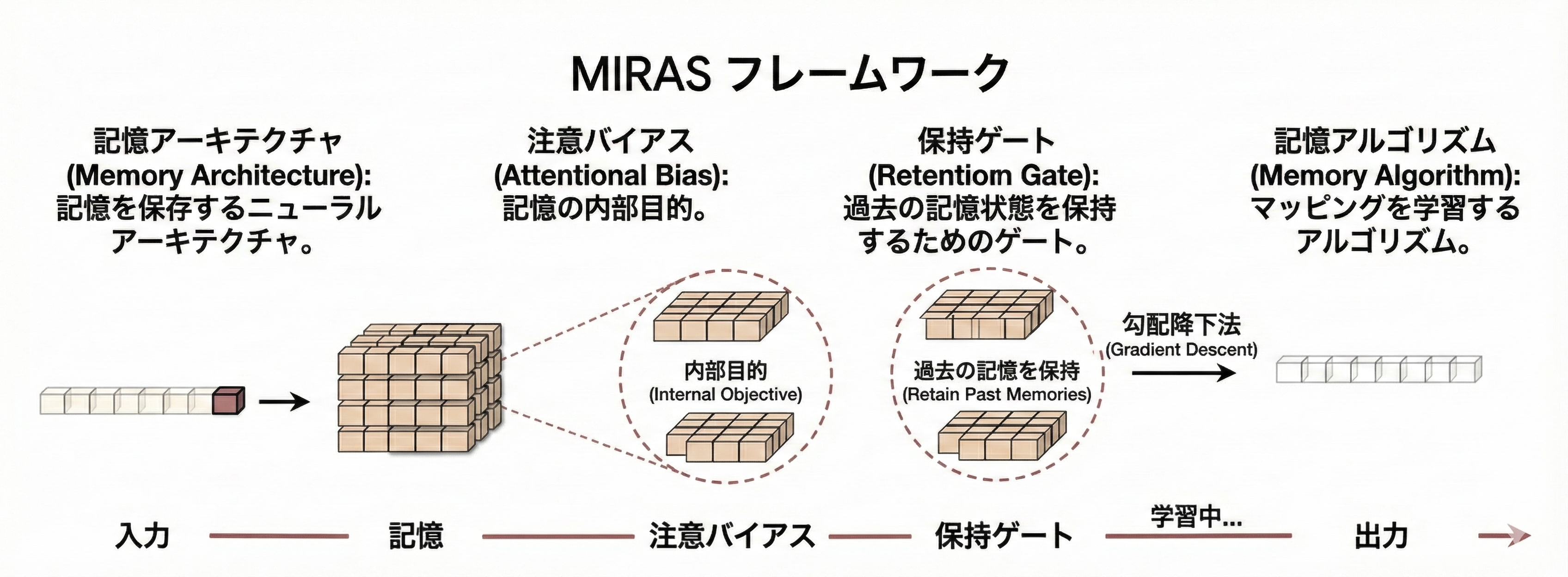

MIRAS(Memory, Retention, Associative bias, and Sequence modeling)は、こうした長期記憶設計を統一的に理解・構築するための理論枠組みであり、記憶アーキテクチャ、注意バイアス、保持ゲート、記憶更新アルゴリズムといった主要な設計選択を定義する。MIRASは従来のTransformerやRNNを同じ連想記憶モジュールの特殊ケースとして捉え、AIモデルが新旧情報を効果的に統合しつつ本質的な知識を失わない設計空間を提供する点が特徴だ。

Googleの研究では、Titansアーキテクチャが従来のTransformerベースモデルや近年の線形リカレントモデルに対して、言語モデリングや長文理解タスクなどで優れた性能を示したという実験結果が示されている。また、2百万トークンを超える極長コンテキストでも高精度の推論を維持できる点が注目されている。

この技術は単なる処理速度の改善だけでなく、AIが大規模文書、長期対話、時系列データ、ゲノム解析など幅広い応用領域でより豊かな理解力を発揮する基盤となる可能性があるとされている。GoogleはTitansとMIRASを通じ、AIモデルの記憶能力の強化という重要課題に取り組むとともに、次世代AIシステムの基礎となる設計理論を提示した。

AI・生成AIのおすすめコンテンツ

AI・生成AIの関連コンテンツ

PR

PR

PR