- 会員限定

- 2022/11/08 掲載

量子コンピューターとは何かをわかりやすく図解、何がすごい?仕組みは?従来と何が違う?

主に技術系の書籍を中心に企画・編集に携わる。2013年よりフリーランスで活動をはじめる。IT関連の技術・トピックから、デバイス、ツールキット、デジタルファブまで幅広く執筆活動を行う。makezine.jpにてハードウェアスタートアップ関連のインタビューを、livedoorニュースにてニュースコラムを好評連載中。CodeIQ MAGAZINEにも寄稿。著書に『ハッカソンの作り方』(BNN新社)、共編著に『オウンドメディアのつくりかた』(BNN新社)および『エンジニアのためのデザイン思考入門』(翔泳社)がある。

量子コンピューターとは?なぜ“夢の計算機”なのか

これまでコンピューターの性能を引き上げてきたのは、基本的には半導体技術の進歩だ。半導体の回路を小型化し、たとえばk分の1に細かくすると動作速度がk倍あがり、回路の集積度はkの2乗になり、消費電力がk分の1に下がるという具合に進んできた。開発メーカーはチップ上の論理ゲートの数をいかに増やし、高速化、高機能化、大容量化、低価格化するかでしのぎを削ってきた。もちろんアルゴリズムの進化という面もある。さらには、ディープラーニング+GPUといった機械学習技術の登場によってコンピューターの性能は大きく向上し、"できること"を格段に広げている。

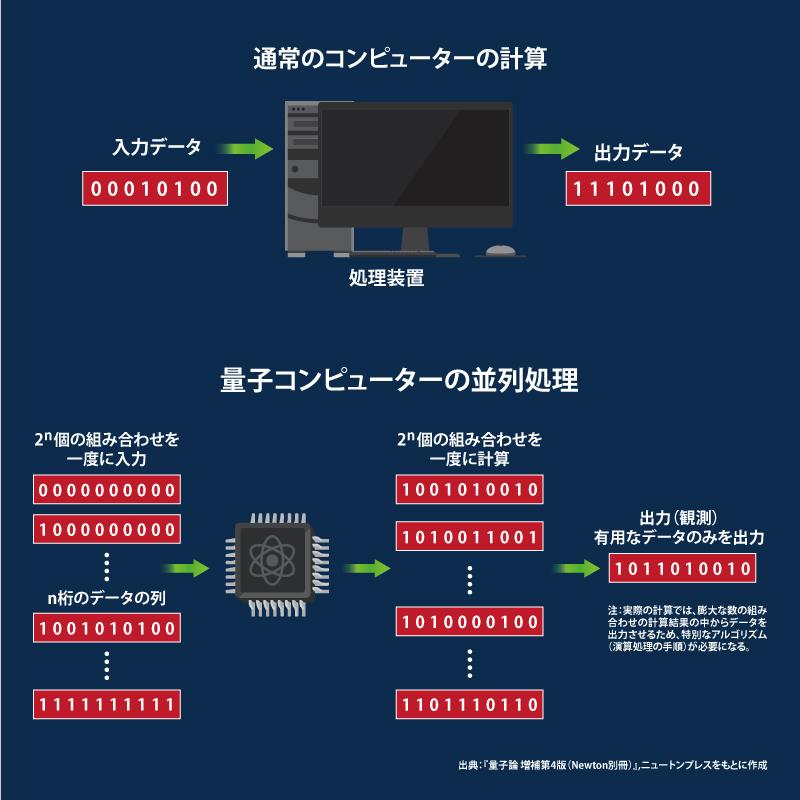

ただ、コンピューターの根本の動作原理自体は変わらない。現在のコンピューターは電圧の高低で「0」と「1」による2ビットを表し、ビットで論理演算(論理演算を行う電子回路を「論理ゲート」という)を行う。どんなプログラムも最終的にはビットの演算処理で実行される。

その仕組みが変わらない以上、「コンピューターをより高性能にする」というのは、上述したように(論理ゲートの数を増やし回路を小型化する、などにより)チップ上の回路の集積度を上げて計算処理スピードを得る、ということになる。

しかし、集積率の向上にはいずれ物理的限界が来る。また、従来のコンピューターでは計算できない、「組み合わせ爆発」現象を起こしてしまう最適化問題も存在している。こうした、いまだ解析しきれていない事象を扱うため、スーパーコンピューターを含め、次世代コンピューティングの研究開発が行われている。

量子コンピューターもその1つ。従来のコンピューターとは異なる動作原理で「計算するプロセス」を実現しようというもので、「重ね合わせ」や「量子もつれ(エンタングルメント)」といった量子力学的な振る舞いを使って計算を行うシステムだ。特に注目が続く理由は、実用化されれば革新的な性能が得られるという期待感にある。

量子コンピューターが話題になり始めた頃よく言われていたのが、ICT技術のさまざまな場面で使われているRSA暗号を解いてしまうという脅威論だ。それくらいの進化が起こる可能性が量子コンピューターにはあるということになる。

商用の量子コンピューターが登場している今、その話はどうなのかというと、まだ技術的にそこまでの性能に至っていないため、すぐにでもRSA暗号が破られてしまうという状況ではないというところだ。そのあたりも含めて、本稿では量子コンピューターの基礎とその可能性を見ていこう。

▼この記事の内容を3分の動画・音声でまとめています▼

量子コンピューターの原理となる量子の「振る舞い」

ミクロのスケールでの物質の振る舞いには、私たちが知覚できる世界の認識とはまるで違う、次の2つの特徴がある。・1つのものが同時に複数の場所に存在する(状態の共存)

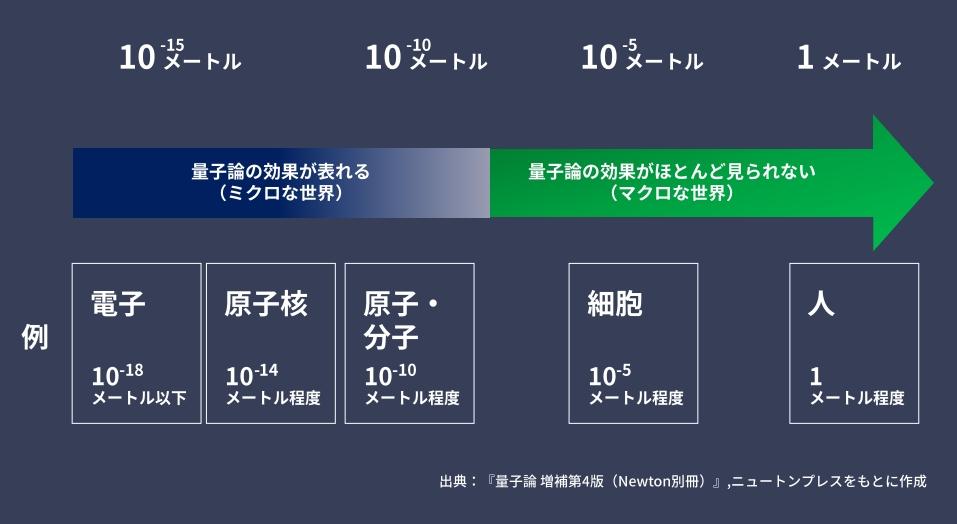

マクロな物体の運動は、いわゆるニュートン力学を基本とする古典的な物理法則を使った計算でも、量子論を用いた計算でも同じ結果になるという。ただ、原子以下の大きさ、電子や分子のサイズ(約1000万分の1mm)となると、量子力学で考えないと説明できない現象が現れる。それが、量子の振る舞い、量子の性質のとらえにくさ、マニピュレートのしにくさにつながっている。

ここで、量子コンピューターの原理となる量子の「振る舞い」について見ておこう。ただ、あくまで量子コンピューターに使われる(とされている)特徴ということで、量子論としての解説ではないので、その部分はご了承いただきたい。

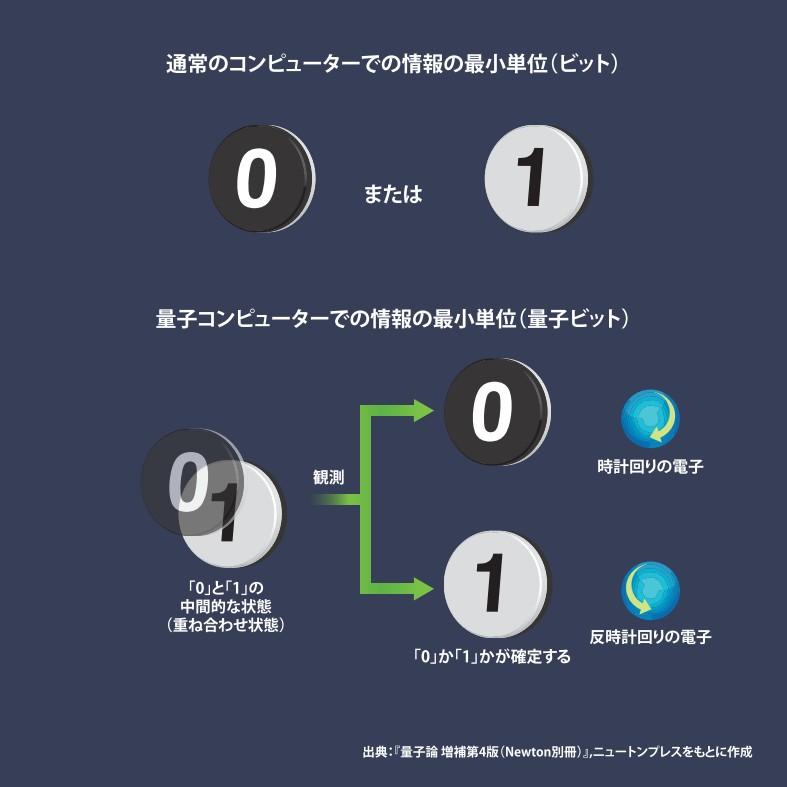

まず量子の持つ特徴として「状態の共存」があることは先に述べた。1つのものが同時に複数の場所に存在する、複数の状態を持ちうる。この「重ね合わせ状態(共存した状態)」を使ってビット(量子ビット)を表現するのだ。

たとえば、粒子の持つ物理量の1つである「スピン(≒自転)」を使って、ある電子の右回りのスピンを「0」、左回りのスピンを「1」としたとき、重ね合わせ状態にある電子はこの「0」と「1」を同時に持つことができる。こうした電子を2つ用いて、「00」「01」「11」「10」を表現できるということになる。

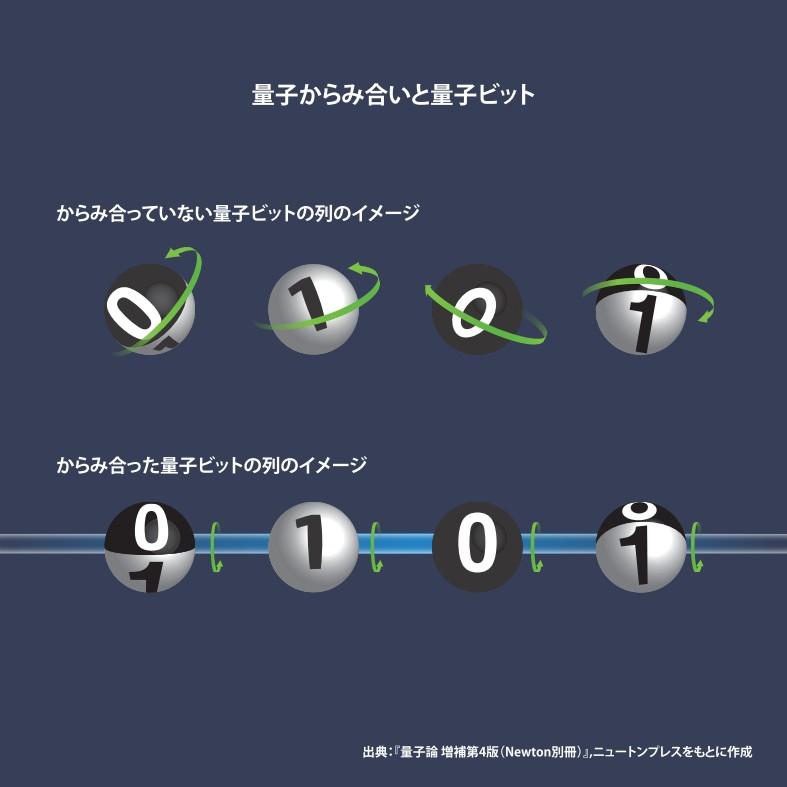

もう1つ重要なのが「量子もつれ(エンタングルメント、量子からみ)」と呼ばれる、量子の特徴だ。量子もつれの状態にある2つの電子があるとき、一方の電子において右回りのスピンが“観測”された場合にもう一方は左回りのスピンが確定する。つまり、1つが右(左)回りであるとき、もう1つは左(右)回りである、という状態が量子もつれだ。量子もつれの状態にある2つの電子は、このようにスピンの値を打ち消し合う。

これが量子コンピューターになぜ必要なのかというと、高速に並列計算を行うためだ。絡み合っていない量子ビットのビット列は個々に動いてしまう。複数の量子ビットが絡み合っていれば、1つの量子ビットに対する作用を、瞬時に、全体へ及ぼすことができる。

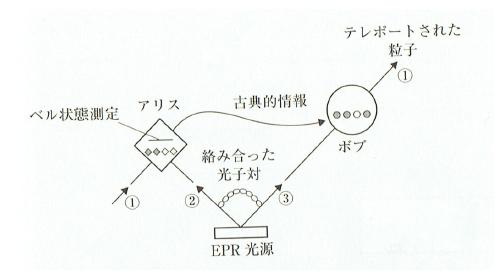

ちなみに、この量子もつれの特性を用いたものに「量子テレポーテーション」がある。アリスとボブの2者の間で量子もつれにある光子の対を、アリスが光子(a)、ボブが光子(b)というように持つ。そして、この光子対には重ね合わせ状態を持つ量子ビット(c)がある。このときアリスが(a)と(c)を一緒に観測し、その”結果”をボブに伝えると、ボブはその情報をもとに(b)を操作することで(c)が得られる、というものだ。

暗号鍵の交換方法としても非常に魅力的であるとともに、量子テレポーテーションは量子通信という新たなネットワークの可能性を示している。量子もつれの制御、通信距離を伸ばすための技術など、各国さまざまな研究機関がこうした量子テレポーテーションの研究に取り組んでいる。

たとえば、1998年古澤明(現・理化学研究所)が量子テレポーテーションの実験に成功(無条件下で成功したのは世界初のこと)。その後、3者間の量子もつれ制御(2004年)、9者間の量子もつれ制御に成功(2009年)。また、2016年に中国が宇宙規模での量子実験を目的に打ち上げた実験衛星「墨子号」は、地球上の1200キロ離れた2つの地点間における量子テレポーテーションに成功するなどの成果をあげているという。

2021年には、理化学研究所、シドニー大学、ルール大学ボーフム校による共同研究チームが「3量子ビットの量子テレポーテーション」を成功させている。

【次ページ】量子ゲート方式での量子による計算とは

量子コンピューターのおすすめコンテンツ

PR

PR

PR