- 2021/04/27 掲載

東北大学と大阪大学、AIの説明能力を客観的に評価するための方法論を構築

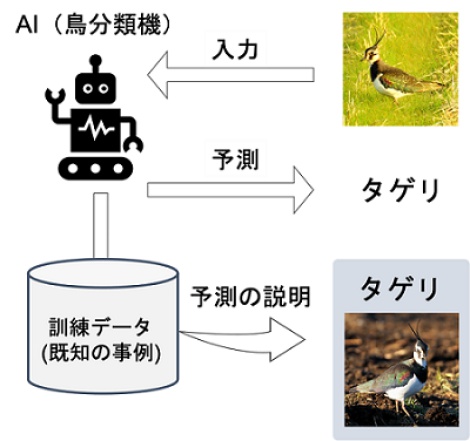

〇AIが下した判断の根拠を明示する手法として、AIが判断を下すに際して参照した過去の類似事例を人間に提示するアプローチが注目されている。

〇類似事例を見つけるための技術的な方法は複数の提案があるが、人間への説明としてどの方法が適切かはわかっていない。

〇予測根拠として最低限満たすべき要件を定式化したところ、非常に人気の高い手法も含め、既存の手法の多くは要件を満たさないことを指摘した。

〇本研究を足がかりに、人間社会に自然に溶け込むAIの研究開発が加速することが期待される。

【概要】

深層学習をはじめとする多くの機械学習手法は、様々な応用分野でその有用性が示されています。一方で機械学習手法は、その判断根拠が不明な点が問題視されています。医療や教育などの分野では特に、「AIがそのような判断をした理由」を知り伝えることが運用上極めて重要です。そのため、最近では「説明可能AI」という標語の下、AIの判断根拠を示すための研究が盛んに行われています。

説明可能AIの有力なアプローチのひとつとして、AIが判断のために参照した過去の類似事例を提示する方法があります。東北大学情報科学研究科/理化学研究所の塙一晃研究員、横井祥助教、乾健太郎教授、大阪大学産業科学研究所の原聡准教授らの研究グループは、「類似事例に基づく説明可能AI」が本当に良い説明を提供しているのかを確かめるため、説明可能AIが最低限満たすべき要件を定式化し、既存の手法群を再評価しました。研究の結果、既存の手法のいくつかは要件を満たせておらず、要件を満たさない手法群には共通の特徴があることを明らかにしました。

研究成果は、現在AI・機械学習分野でもっとも競争的でインパクトの大きい査読付き国際会議(1)であるThe Ninth International Conference on LearningRepresentations(ICLR 2021)に採択されました。

PR

PR

PR