- 2026/02/15 掲載

OpenAI、リアルタイムコーディング向け高速モデル「GPT-5.3-Codex-Spark」を発表

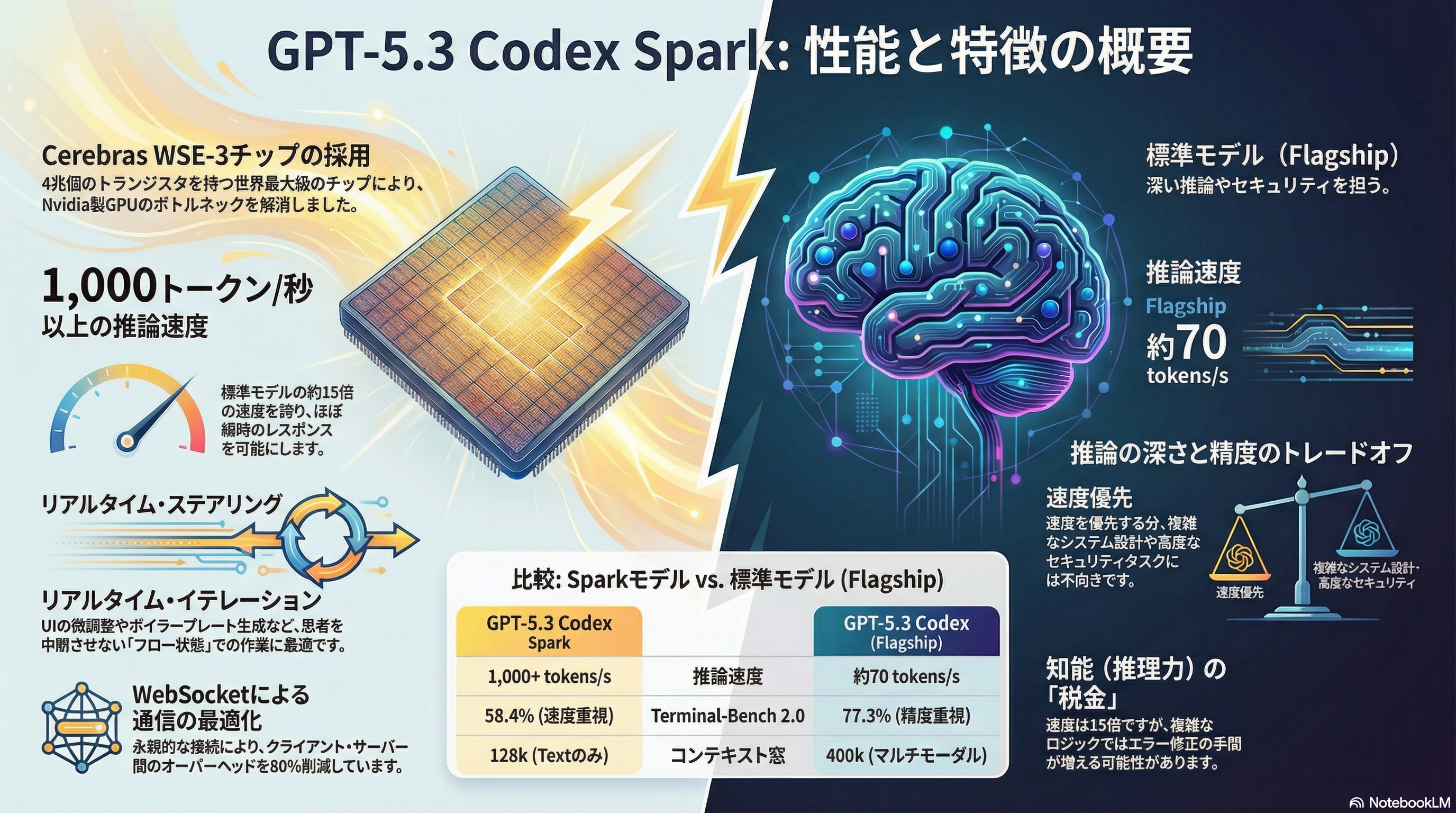

Cerebrasの巨大プロセッサ「Wafer Scale Engine 3」上で動作、毎秒1000トークンを超える生成速度を実現

このモデルは、同社が先日リリースした「GPT-5.3-Codex」の小型版に位置づけられ、長時間に及ぶ自律的なタスク遂行を得意とするメインラインのモデルとは異なり、開発者がコードエディタ上で対話的に行う修正やリファクタリングといった即時性が求められる作業に特化している 。最大の特徴は、AIハードウェア開発企業であるCerebras Systemsとのパートナーシップにより、同社の巨大チップ「Wafer Scale Engine 3(WSE-3)」を推論インフラに採用した点にある。

WSE-3は単一のシリコンウェハー上にメモリと演算回路を集積したプロセッサであり、従来のGPUクラスタで発生していたチップ間の通信ボトルネックを解消することで、毎秒1000トークンを超える超高速なテキスト生成を可能にした 。

加えてOpenAIは、クライアントとサーバー間の通信に持続的なWebSocket接続を導入し、リクエストから応答までのパイプライン全体を刷新することで、ラウンドトリップのオーバーヘッドを80%削減し、最初のトークンが表示されるまでの時間を半減させるなど、徹底した低遅延化を図っている 。これにより、ユーザーはAIの生成をリアルタイムで遮ったり、方向修正したりといった「ペアプログラミング」に近い直感的な操作感が得られるとされる。

機能面では、テキスト入力のみに対応し、コンテキストウィンドウは128kトークンとなっている 。高速化に特化したトレードオフとして、複雑な推論能力やサイバーセキュリティ分野での高度な能力については、フラッグシップモデルである「GPT-5.3-Codex」と比較して意図的に抑えられており、OpenAIの安全性評価においてもサイバーセキュリティや生物学的な脅威を生じさせるリスクは低いと判断されている 。

提供形態については、現時点では「Codex」アプリ、コマンドラインインターフェース(CLI)、およびVisual Studio Code拡張機能を通じて利用可能であり、APIに関しては一部のパートナー企業から順次提供範囲を拡大していく予定である。

AI・生成AIのおすすめコンテンツ

AI・生成AIの関連コンテンツ

PR

PR

PR