- 2026/01/15 掲載

OpenAI、NEXT NVIDIAと目される「Cerebras」と提携、AI推論高速化を目指す

Cerebrasが設計する専用AIチップを自社のコンピューティング基盤に統合、AIモデルの応答性能を大幅に向上

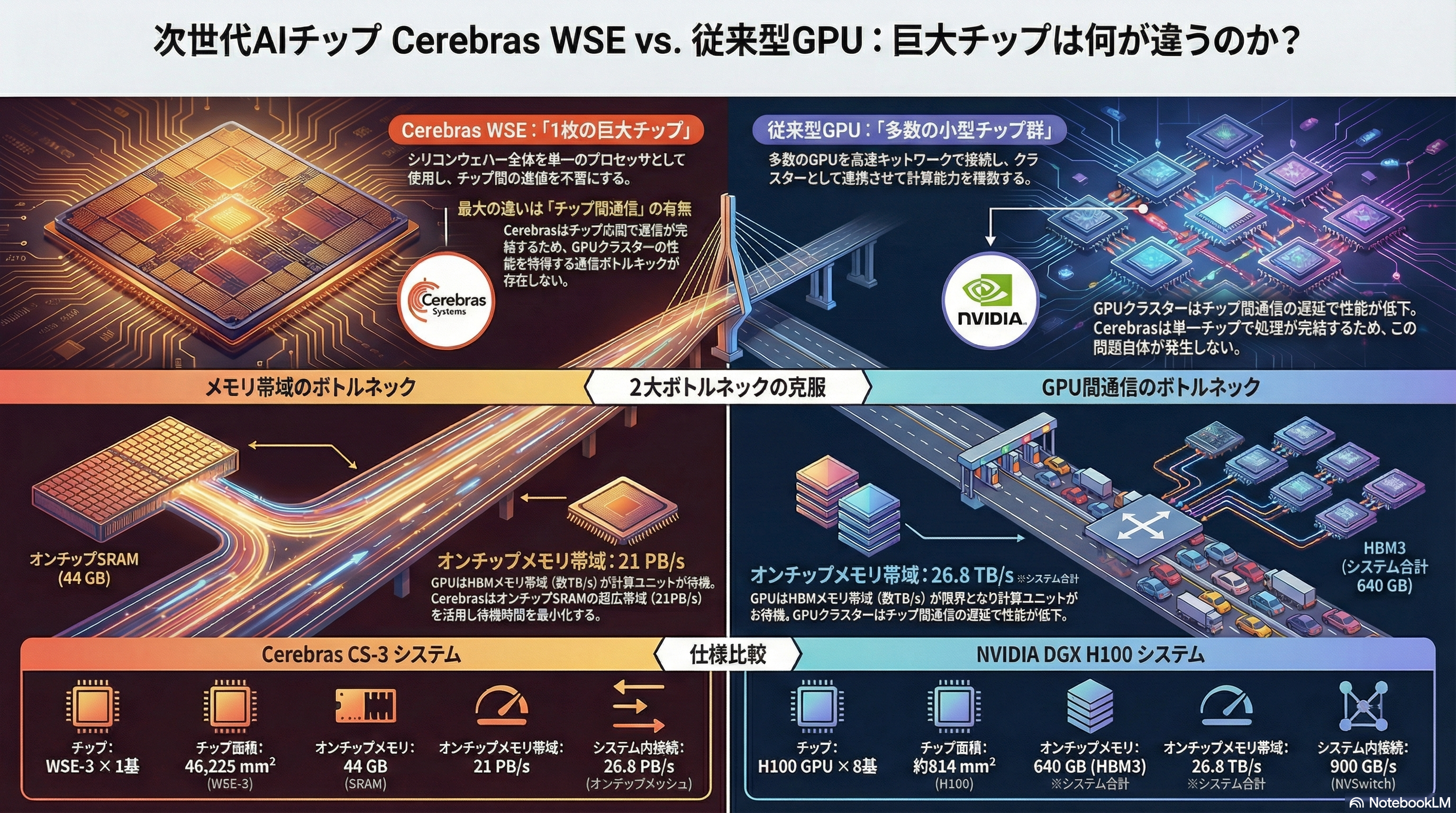

今回の提携によりOpenAIはCerebrasのAIチップベースのインフラを自社の推論処理スタックに統合し、従来よりも高速なAI応答を実現することを狙う。OpenAIのインフラ戦略責任者であるサチン・カッティ氏は、Cerebrasの低遅延推論ソリューションの導入が「より高速な応答と自然なインタラクション、広範なリアルタイムAIの提供基盤となる」とコメントしている。

Cerebras側も、提携についてAIモデルを高速に稼働させる技術の市場展開を拡大する機会と位置づけている。共同創業者でCEOのアンドリュー・フェルドマン氏は、従来のGPUに比べて推論処理速度が大幅に向上することで、AIとの対話やリアルタイム推論を必要とするアプリケーションが広く実現可能になると述べていると報じられている。

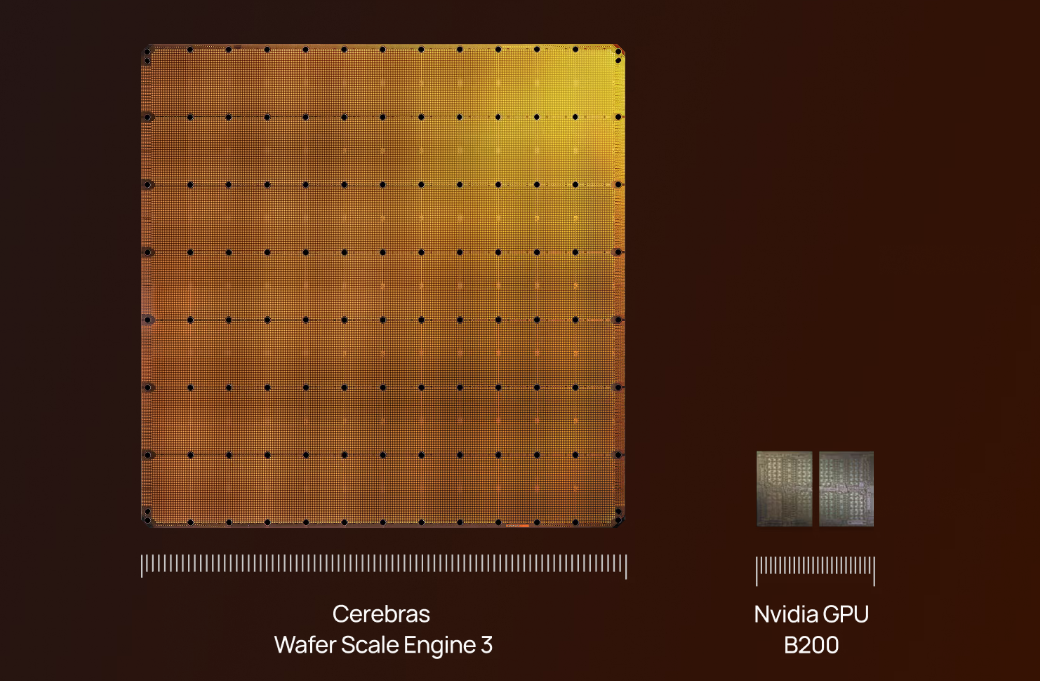

複数の報道によれば、OpenAIとCerebrasの提携契約は100億ドル(約1兆5800億円)を超える規模に上る可能性があり、大規模AIインフラへの投資としては極めて大きいものとなる見込みだ。Cerebras製のチップは、NVIDIAやAMDといった従来型チップメーカーの製品に対抗する性能を持つと評価され、一部のベンチャーや企業が採用を進めている。

OpenAIはこれまでにも複数のハードウェアベンダーとの提携やチップ開発戦略を進めており、今回のCerebrasとの協力はその一環と位置づけられる。こうした大規模な計算リソースの確保は、ChatGPTなどの人気AIサービスの性能向上と、将来的なAIモデルの高性能化に不可欠とされる。今回の提携は、AIのリアルタイム応答性能に関する技術的課題をハードウェア面から解決し、ユーザー体験の向上につながる可能性がある。

AI・生成AIのおすすめコンテンツ

AI・生成AIの関連コンテンツ

PR

PR

PR