- 会員限定

- 2024/07/16 掲載

【完全解説】NECの生成AI戦略、独自の生成AI「cotomi」はGPT-4らとどう差別化する?

連載:デジタル産業構造論

株式会社d-strategy,inc 代表取締役CEO、東京国際大学 データサイエンス研究所 特任准教授

日立製作所、デロイトトーマツコンサルティング、野村総合研究所、産業革新投資機構 JIC-ベンチャーグロースインベストメンツを経て現職。2024年4月より東京国際大学データサイエンス研究所の特任准教授としてサプライチェーン×データサイエンスの教育・研究に従事。加えて、株式会社d-strategy,inc代表取締役CEOとして下記の企業支援を実施(https://dstrategyinc.com/)。

(1)企業のDX・ソリューション戦略・新規事業支援

(2)スタートアップの経営・事業戦略・事業開発支援

(3)大企業・CVCのオープンイノベーション・スタートアップ連携支援

(4)コンサルティングファーム・ソリューション会社向け後方支援

専門は生成AIを用いた経営変革(Generative DX戦略)、デジタル技術を活用したビジネスモデル変革(プラットフォーム・リカーリング・ソリューションビジネスなど)、デザイン思考を用いた事業創出(社会課題起点)、インダストリー4.0・製造業IoT/DX、産業DX(建設・物流・農業など)、次世代モビリティ(空飛ぶクルマ、自動運転など)、スマートシティ・スーパーシティ、サステナビリティ(インダストリー5.0)、データ共有ネットワーク(IDSA、GAIA-X、Catena-Xなど)、ロボティクス・ロボットSIer、デジタルツイン・産業メタバース、エコシステムマネジメント、イノベーション創出・スタートアップ連携、ルール形成・標準化、デジタル地方事業創生など。

近著に『メタ産業革命~メタバース×デジタルツインでビジネスが変わる~』(日経BP)、『製造業プラットフォーム戦略』(日経BP)、『日本型プラットフォームビジネス』(日本経済新聞出版社/共著)。経済産業省『サプライチェーン強靭化・高度化を通じた、我が国とASEAN一体となった成長の実現研究会』委員(2022)、経済産業省『デジタル時代のグローバルサプライチェーン高度化研究会/グローバルサプライチェーンデータ共有・連携WG』委員(2022)、Webメディア ビジネス+ITでの連載『デジタル産業構造論』(月1回)、日経産業新聞連載『戦略フォーサイト ものづくりDX』(2022年2月-3月)など。

【問い合わせ:masahito.komiya@dstrategyinc.com】

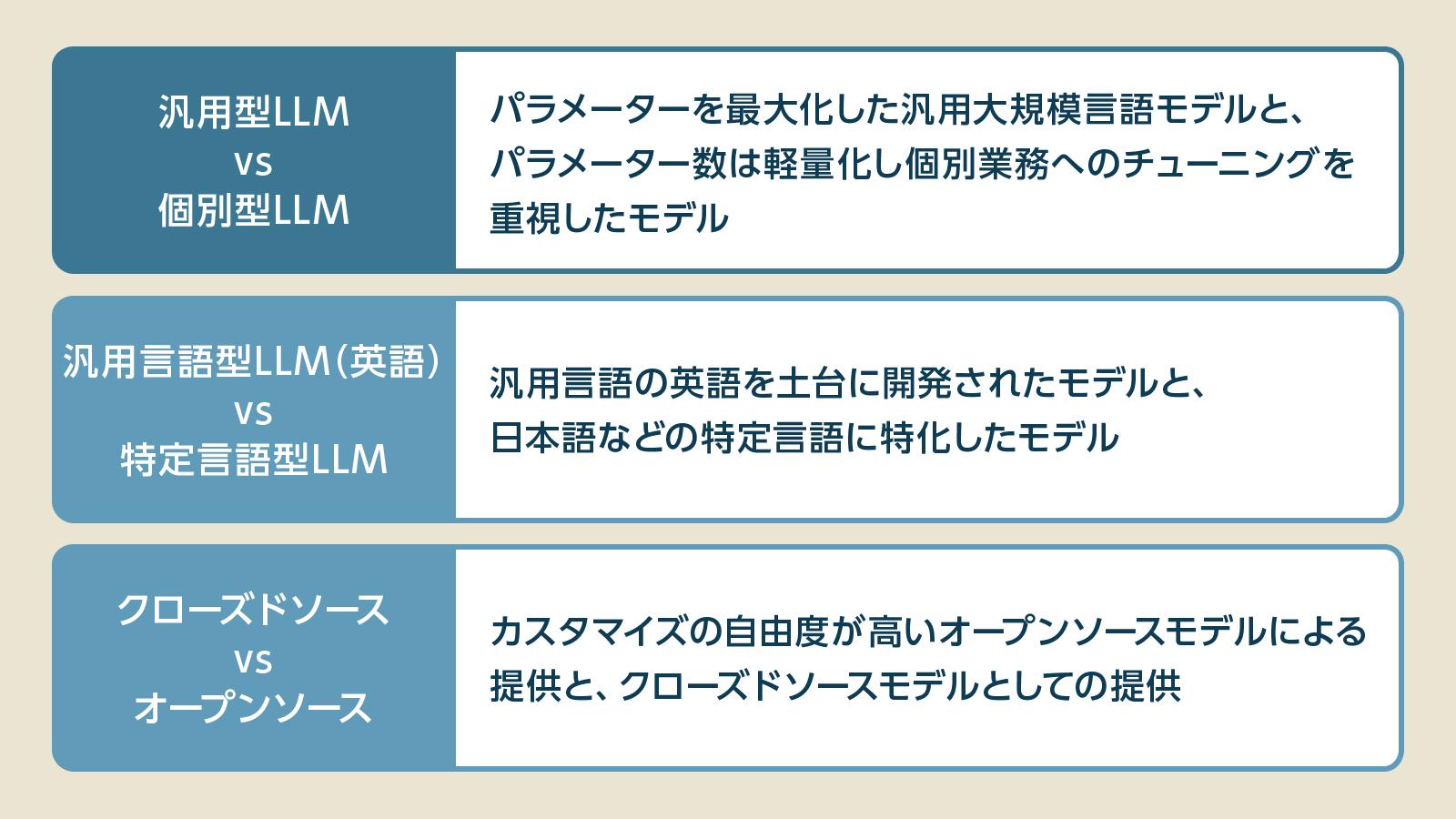

【現状整理】言語モデル「3つの開発パターン」

現在、生成AIの産業・ビジネス用途の活用が急速に進んできている。すでに業務の中でChatGPTのような生成AIサービスを活用する段階から、既存の業務オペレーションに生成AIを組み込んだり、生成AIをベースに新サービスを展開する事例も出始めている。そのような中で、LLM(大規模言語モデル)開発としては、開発の方向性のパターンも生まれてきている。下記が開発の方向性のパターンだ。本記事では、このうち(1)について触れたい。

(1)汎用型LLM vs 個別型LLM

・パラメーターを最大化した汎用LLMと、個別業務へのチューニングを重視した個別型LLM(後述)

(2)汎用言語型LLM(英語) vs 特定言語型LLM

・汎用言語の英語を土台に開発されたLLMと、日本語などの特定言語に特化したLLM

例:GPT(汎用言語)⇔ NEC cotomi、NTT Tsuzumiなど(日本語特化)/National Multimodal LLM Programme(シンガポール政府によるASEANローカル言語に対応した言語モデル)

(3)クローズドソース vs オープンソース

・カスタマイズの自由度が高いオープンソースモデルによる提供と、クローズドソースモデルとしての提供

例:メタ Llama(※同社はオープンソースとして提供すると発表)⇔ GPT(クローズドソース)

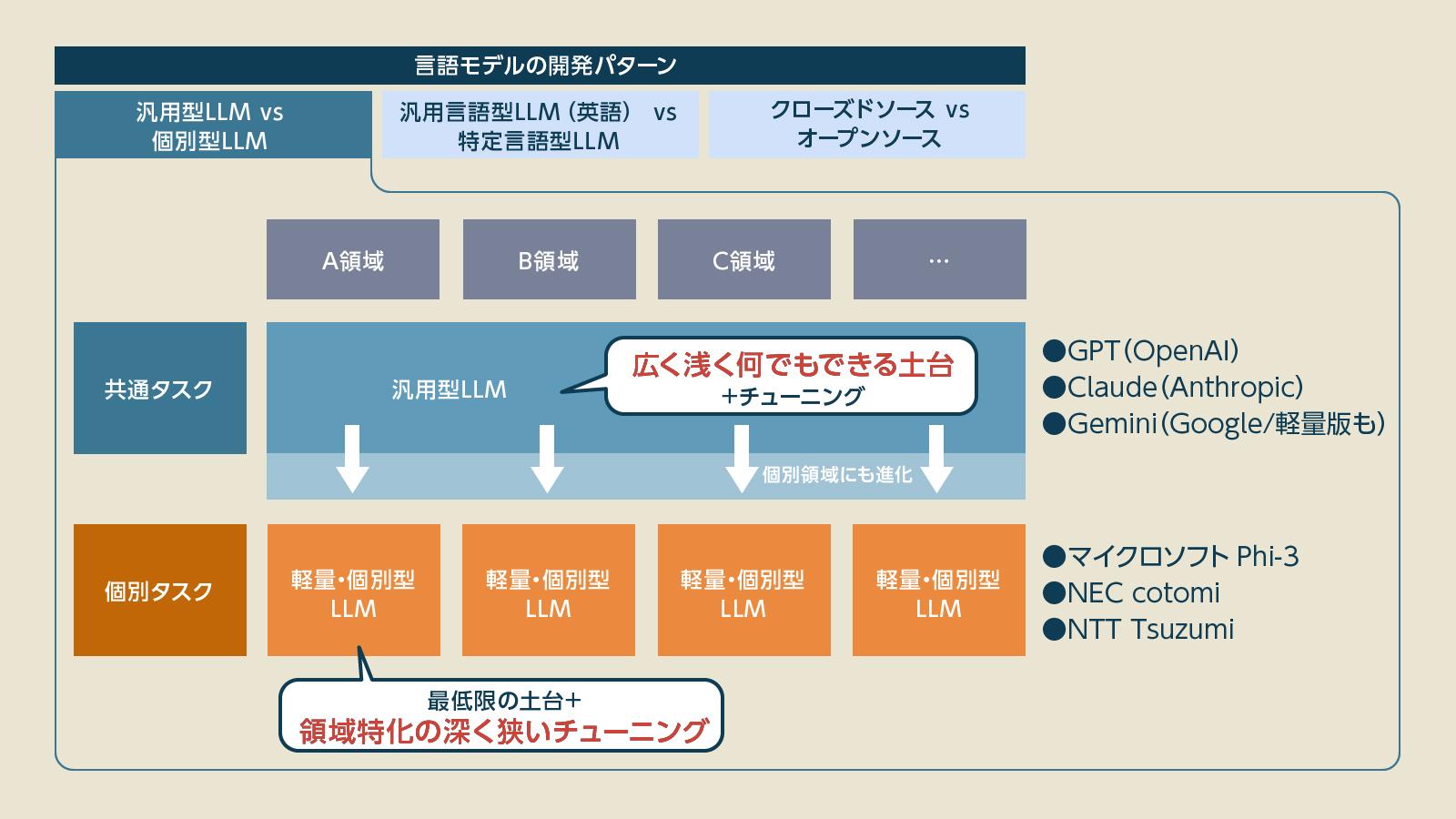

競争は激化? 汎用型LLM vs 個別型LLM

本記事においては、特に、汎用型LLM vs 個別型LLMの競争について触れていく。この戦いにおける汎用LLMとは、OpenAIが展開しているChatGPTや、アンソロピックが展開しているClaudeなどが代表例として挙げられる。汎用型LLMは、大規模なパラメーターを学習させて、さまざまなタスクに対応できるよう開発される。一方で、個別業務へのチューニングを重視したモデルが個別型LLMだ。言い換えれば、「広く浅く何でもできる」汎用の土台を構築する汎用LLMモデルに対して、最低限の土台を構築し個別業務での「狭く深いカスタマイズ」を重視するのが個別型LLMである。

そうした個別型LLMとして、独自開発の「cotomi」を展開するのがNECだ。ここからは、「cotomi」の実力、企業や産業の個別課題の解決を重視するNECの生成AI戦略を中心に、言語モデルの競争についても見ていきたい。

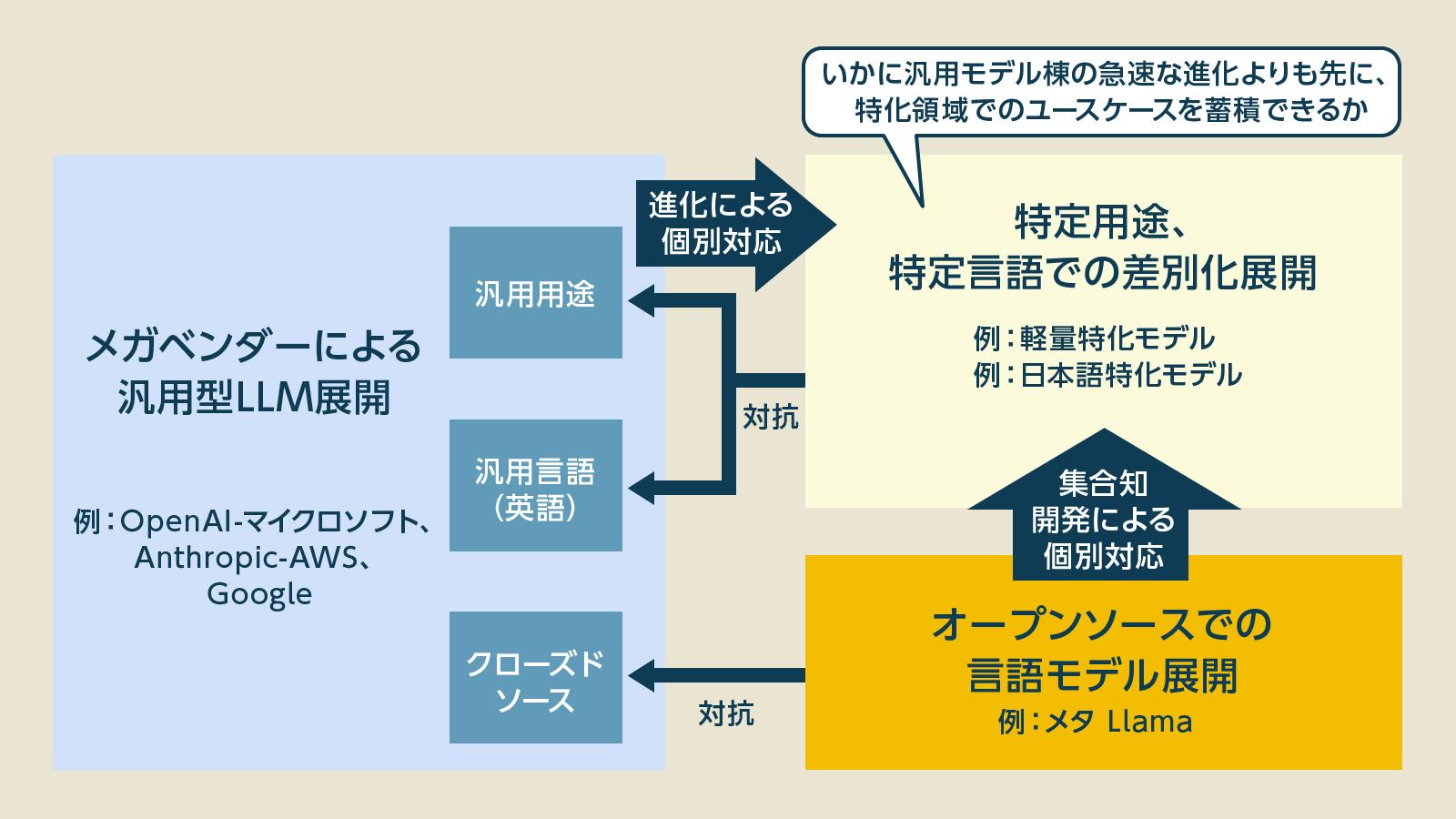

汎用型LLMにどう勝つ? 「個別型LLM」成功の条件

はじめに、言語モデルの開発・競争環境を整理すると、(1)メガベンダーによる汎用型LLM、(2)個別型LLM、特定言語型LLMモデルなどによる差別化モデル、(3)オープンソースによる言語モデル展開などのパターンが存在する。このうち、NECの個別型モデル「cotomi」(後述)が含まれる(2)の特化型の展開の戦い方については、汎用型LLMの汎用性の高さに対して、個別業務へのカスタマイズ性・寄り添いによって勝負を仕掛けている状況がある。

とはいえ、LLMも急速に進化している。ChatGPTをはじめ新たなモデルにおいて大幅な機能拡張が発表される。今後、個別領域の対応能力を有していくことが想定される。

加えて、メタのLlamaなどのように、オープンソースとして展開すると発表されている言語モデルに関しても、さまざまなプレイヤーが開発に参加し、急速に個別領域に対応したサービスが開発されていくと見られている。

そのため、個別型LLMの今後の展開としては、これら汎用型LLMや、オープンソースモデルが個別領域のタスクに対応できる進化よりも先に、いかに顧客基盤やユースケース、展開のためのエコシステムを形成できるかが鍵となる。

これら競争におけるポイントを踏まえ、NECの個別型LLM「cotomi」、生成AI戦略に勝算はあるのだろうか。

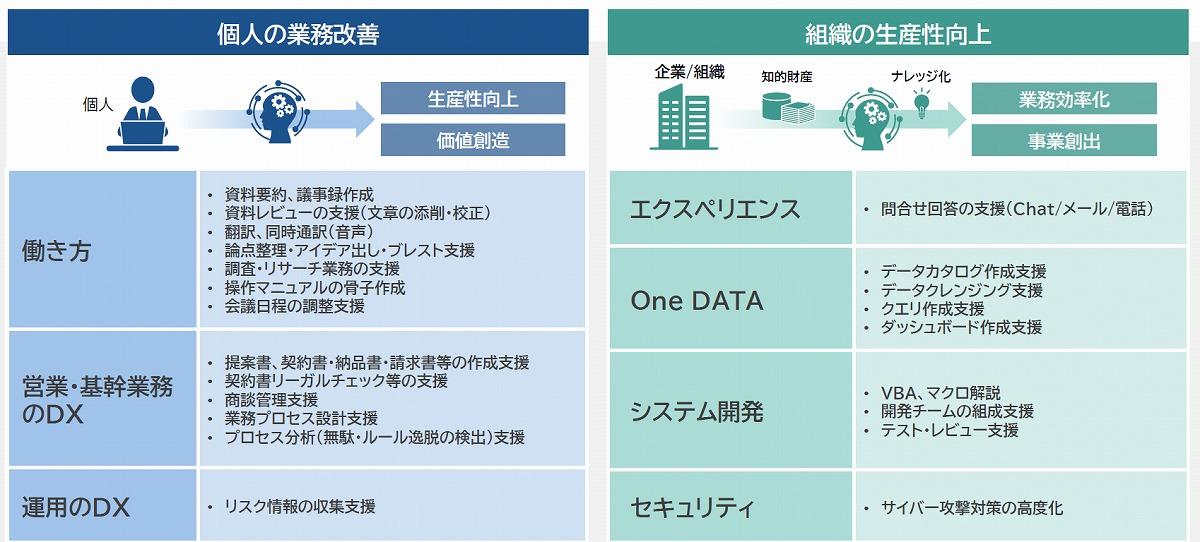

NECの「生成AI展開」の方針

NECは現在、金融業・製造業・官公庁・物流業・小売業など、幅広い企業に対して生成AIソリューションを提供している。同社の生成AI展開は、自社内の徹底的な活用を経て、言語モデルの展開、顧客へのソリューション展開へと広がってきている。NECの自社内のオペレーション改善のための生成AI活用においては、スピード感をもって徹底的に生成AIを使い倒すことに主眼が置かれている。当初から社内活用に全社をあげて取り組んでおり、現在は利用者が3万人を超え、グループ9万人のうち3割は使い倒している状態にある。

NECでは自社を最初のクライアントとして位置付け、テクノロジーを実践し、生きた経験やノウハウを顧客に提供する「クライアント・ゼロ」という考え方がある。この考えの下、自社内のあらゆる業務でのAI活用での経験を標準化・ショーケース化し、他社へのビジネス提供を加速する。

業務特化型のLLM「cotomi」

そんなNECは、日本語に対応し、長文処理能力を他社比最大150倍まで引き上げた30万字を処理できる個別型LLMの「cotomi」を展開している。cotomiは「広く浅い」汎用型LLMではなく、顧客のビジネス・業務の個別用途で「狭く深く」活用することが前提に置かれている。その観点から、パラメーター増大によるトレードオフのバランスを図り、かつ産業・業務のカスタマイズ性を向上させている。パラメーター規模の軸での言語モデル開発の競争とは別の視点での差別化を図っているのだ。

現在、普及している汎用的な生成AIは膨大なパラメーターサイズを有しており、AIとしての精度は高い。しかし、ビジネス・業務用途においては、パラメーター数はさまざまなコストとトレードオフになると同社は捉える。たとえば、下記のトレードオフが存在する。

- 【サーバコスト】

セキュリティ性を考慮し自社でサーバを持つ場合、パラメーターサイズが大きいほど必要GPUが膨大となる - 【消費電力】

パラメーターサイズが上がる分、消費電力が増大する - 【レスポンス速度】

パラメーターサイズが上がる分、業務活用でのレスポンス速度が下がる - 【産業・業務カスタマイズ性】

パラメーターサイズが上がる分、自社や産業のデータや、業務・オペレーションに基づくカスタマイズ性が下がる

こうしたビジネス・業務用途での生成AI活用における既存の大規模パラメーターの言語モデルの課題を解決するべくNECが展開している独自の言語モデルが「cotomi」だ。それでは、「cotomi」でどう戦っていく考えなのか。 【次ページ】なぜ「cotomi」なのか?NECが考える差別化の狙い

AI・生成AIのおすすめコンテンツ

AI・生成AIの関連コンテンツ

PR

PR

PR