- 2026/01/07 掲載

NVIDIA、次世代AIプラットフォーム「Vera Rubin」を発表、AIモデル性能10倍向上

Blackwellアーキテクチャの後継、AIモデルの生成効率 約10倍に向上へ

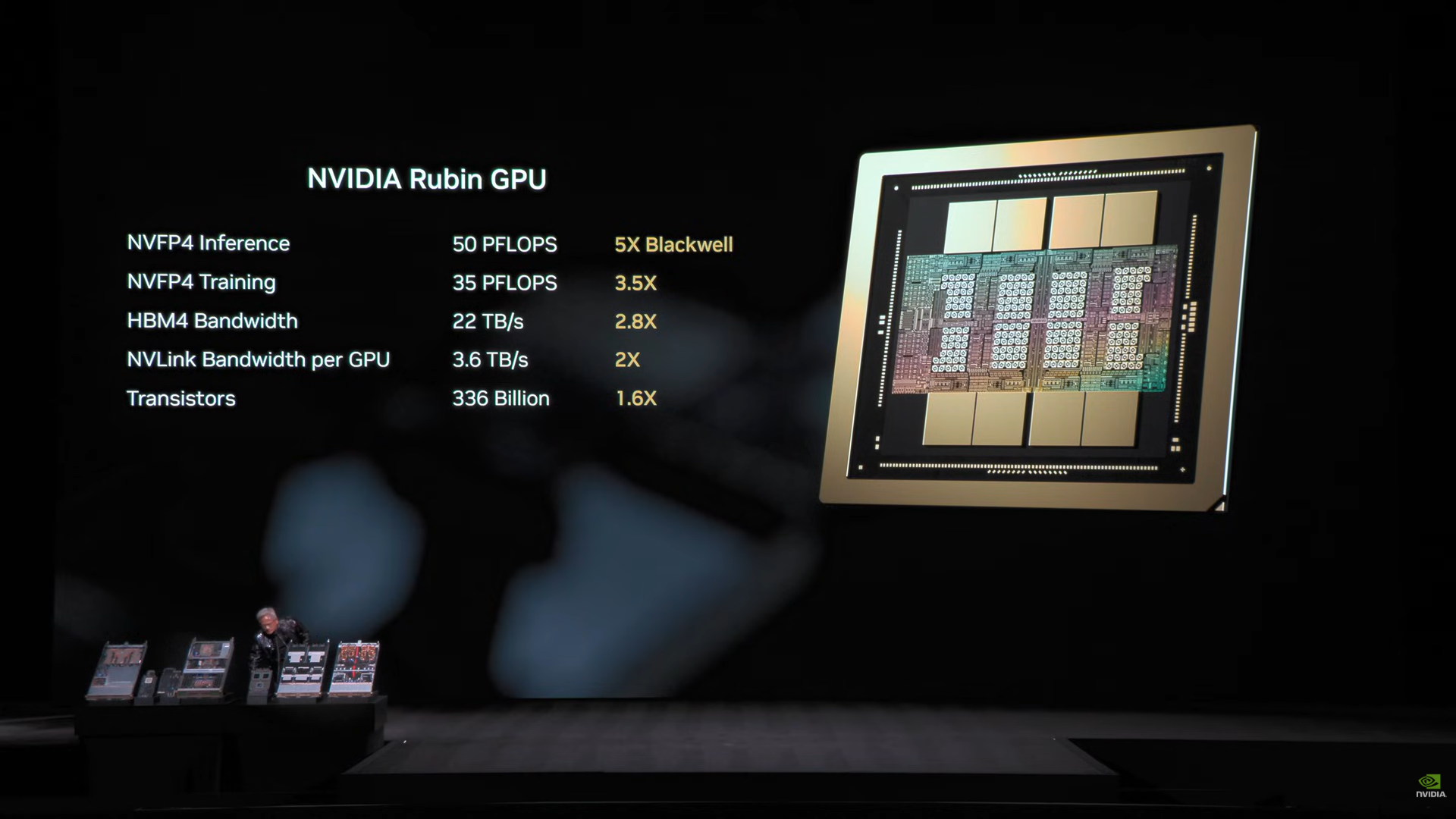

中核となる「Rubin GPU」は、NVIDIAのAI向け処理性能を大きく押し上げる次世代GPUで、AI推論性能はBlackwell世代比で約5倍(NVFP4精度で50ペタフロップス)に達するとされるほか、学習性能でも約3.5倍の性能向上が報告されている。

HBM4メモリの採用により1GPU当たり288GBの容量と22TB/s超の帯域を確保し、大規模モデルの処理を強力に支える。

これに加え、NVIDIAカスタムの「Vera CPU」、GPU間通信を担う「NVLink 6 Switch」、高速ネットワーキングを実現する「ConnectX-9 SuperNIC」、データ処理ユニット「BlueField-4 DPU」、Ethernetスイッチ「Spectrum-6 Ethernet Switch」の6種で構成される。

Vera Rubinプラットフォームは単体でラックスケールのAIスーパーコンピュータとして機能し、複数ラックを組み合わせた「SuperPod」構成にも対応する。また、グローバルな大規模AIモデルの推論・学習に必要なトークン処理効率をBlackwell世代比で最大10倍に引き上げ、推論コストを大幅に圧縮すると報じられている。

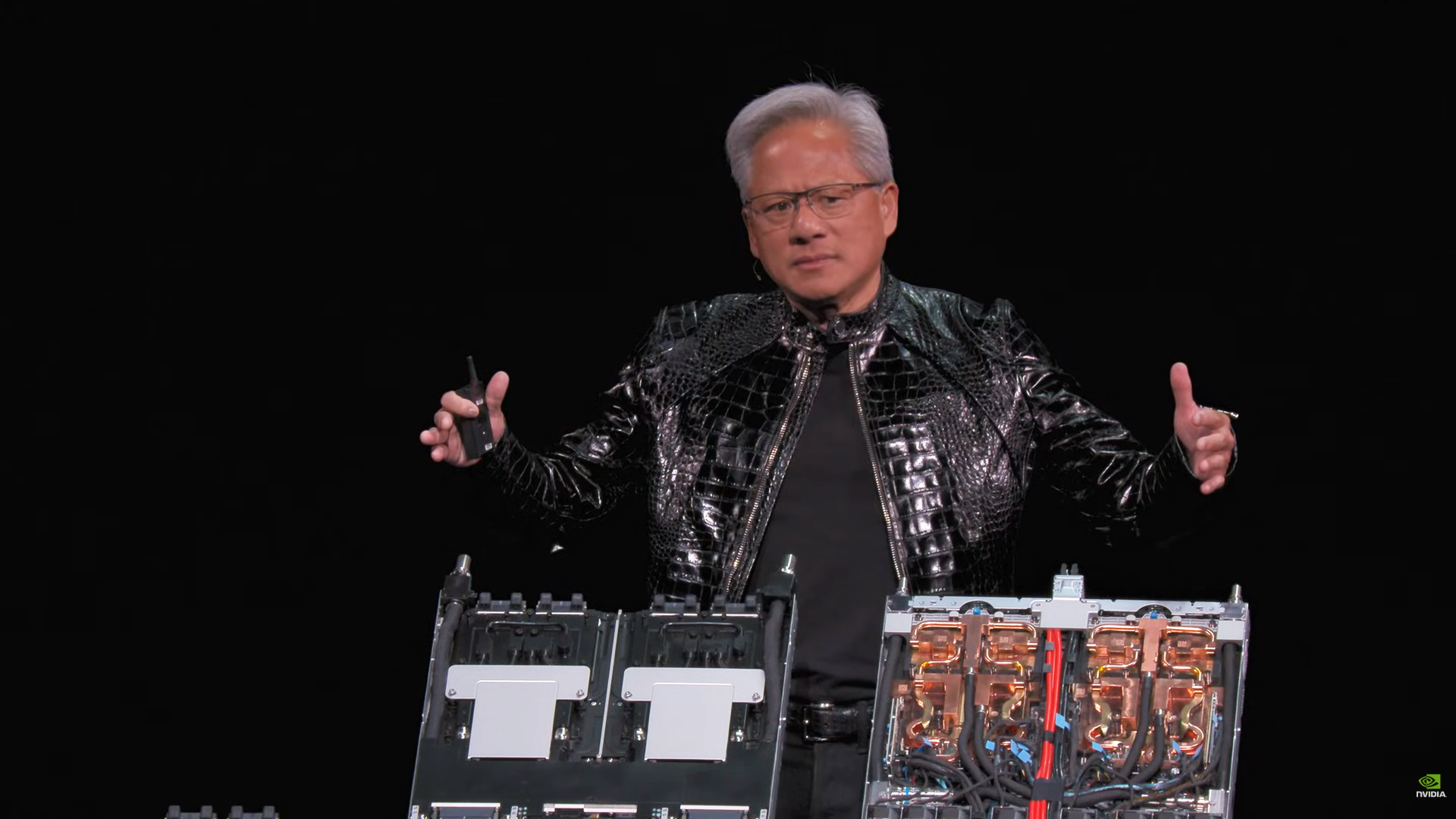

冷却・電源周りでも革新が進められ、100%液冷設計による45℃温水冷却システムによりデータセンターでの導入や運用コストの低減を図るほか、消費電力はBlackwell世代の約2倍となる一方で空気流量は同等レベルに抑え、既存インフラへの適合性を高めている。

NVIDIAのジェンスン・ファンCEOはCES基調講演で、Vera Rubinが「既に量産段階にあり」、2026年後半に市場投入の予定であると述べた。

同プラットフォームはAIモデルのトークン生成効率をBlackwell世代比で約10倍に高めると語っている。複数の業界大手クラウド事業者やデータセンター事業者が採用を表明していることから、主要なAIインフラストラクチャとしての普及が見込まれている。

これにより大規模言語モデルやエージェンティックAI、混合専門家(Mixture of Experts)モデルなどの需要に対応する体制が整うという。

CES 2026ではVera Rubin以外にも、NVIDIAは自動運転向けAIプラットフォームやロボティクスモデルなどを発表しているが、Rubinプラットフォームの発表は同社がデータセンターとAIインフラ事業に最大の経営資源を投入していることを象徴するものとして注目を集めた。

AI・生成AIのおすすめコンテンツ

AI・生成AIの関連コンテンツ

PR

PR

PR