- 会員限定

- 2023/01/16 掲載

AI戦略を策定・実行する4つのポイントをガートナーが解説、成熟企業に共通する5点

ディスティングイッシュト バイス プレジデント, アナリスト

亦賀忠明氏

AI戦略で求められる4つの柱とは

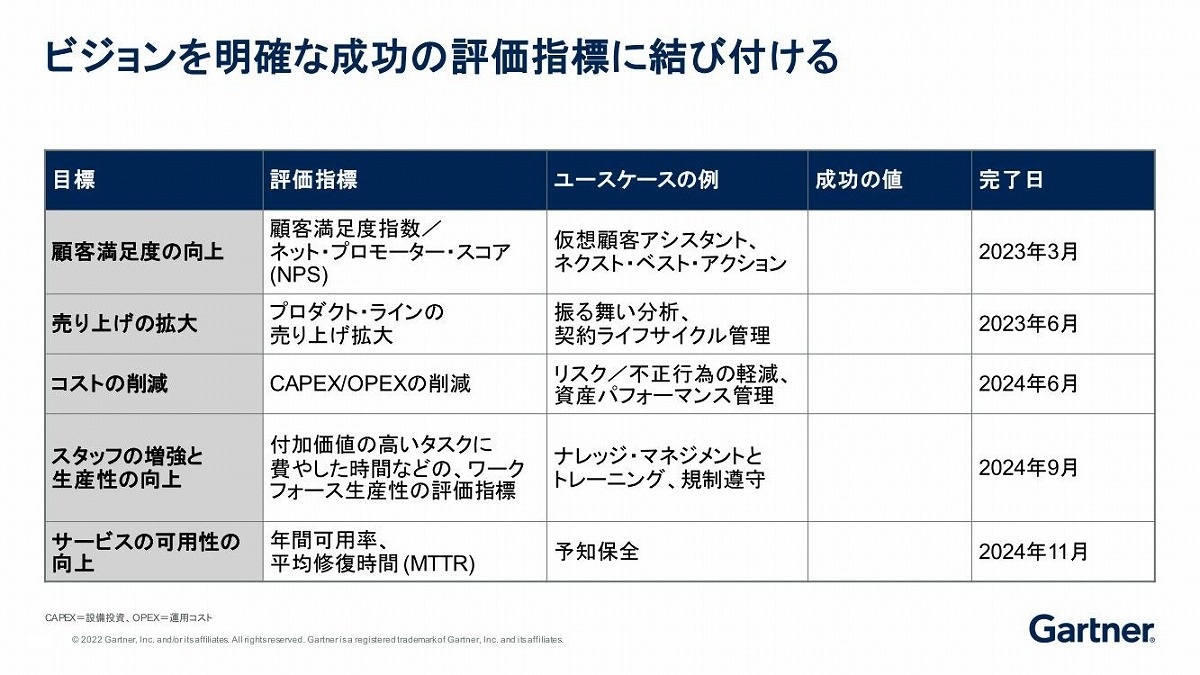

AI戦略を策定する上で重要なのが、「ビジョン」「リスク」「価値」「導入」という4つの大きな柱だ。「ビジョン」における大きな目標は、ビジネス戦略やデジタル化目標との整合していくことにある。

たとえば、すでにあるビジネス戦略にAIを当てはめればいいわけではなく、AIの特性を生かしたビジネス戦略を練り上げる必要がある。さらにそのビジョンを具体的なビジネス価値に転換していくためには、その成果を定量的な指標で評価することも忘れてはならない。

たとえば、ビジネス上の目標が「顧客満足度の向上」ならば、組み込むべきAIのユースケースは仮想顧客アシスタント(チャットボット)やネクスト・ベスト・アクションなどが考えられる。

その場合の評価指標は、顧客満足度指数やネット・プロモーター・スコア(NPS)などが適当だろう。定量的な目標に加え、それを「いつまでに」達成するか、スケジュールを明確にすることも押さえておきたいポイントだ。

ただ、「とにかくAIをやってみた」という事実ばかりを追い求めると、ビジネス目標と整合の取れないAIを入れてしまったり、成否を評価する指標を設けずに始めてしまったりすることになる。すると結果として、ビジネス成果も得られず、失敗から学びを得ることもできなくなってしまう。

亦賀氏は「AIの導入自体が目的になってしまうことはよくある」と指摘する。そうならないために、「ビジネス目標と用いるAIの合致、成否を判断できる指標を一度にらんでおく必要があります」(亦賀氏)

プライバシー、倫理、バイアスのリスクを軽視してはならない

AI戦略においては、導入に伴う「リスク」にも注意を払っておくべきだ。リスクには、大きく分けて3つ、「規制」「評判」「コンピテンシー」に関わるものがある。「規制」の代表的なものとして、法的リスク、コンプライアンス、プライバシー保護に関するものが挙げられる。「特にヨーロッパではこれまでAI規制に関するガイドラインをいくつか出しており、2021年には欧州委員会が欧州AI規制法案を公表しています」と亦賀氏は海外の動きを紹介した。

同法案では、あるタイプのAIは禁止するという厳格な内容もあり、日本の経団連はその定義のあいまいさなどを懸念する意見を表明している。EUだけでなく、規制の動向には注視が必要だ。

「評判」に関するリスクは、バイアス、透明性の欠如、AIの意思決定に関するリスク、AIや機械学習への攻撃などがある。

バイアスというのは、AIが学習するデータに偏りがあることによって、偏見・差別を助長するようなアウトプットが出てしまうような事例だ。たとえば、犯罪予測AIを構築しようと過去のデータで学習させたところ、特定の人種の犯罪可能性を高く判定してしまうといったケースがある。こうしたAIを使うことは、レピュテーションの観点でもリスクが伴う。また、AIのそうした特性を利用して、不適切なデータを学習させるような攻撃も考えられるということだ。

意思決定に関するリスクとは、AIにクリティカルな決定を委ねてしまうことの危険性である。仮に、余命判定AIなるものが作られ、「あなたは1年以内に亡くなります。根拠は分かりません、AIの判定なので」と言われたらということを想像してみてほしい。判断の過程が分からないAIに、クリティカル・ディシジョンをさせてはいけないということだ。

「コンピテンシー」は本来ポジティブな話だが、「コンピテンシーを高めようとするけれどもそれができないリスク」が潜んでいる。たとえば、技術的に難し過ぎてテクノロジー負債となってしまうリスクや、必要なスキルがそろえられないタレントマネジメントの問題、組織内部からのAIに対する抵抗などがそれに当たる。

「これらリスクは一過性のものではなく、継続的に対応していく必要がある」と亦賀氏は指摘する。

コンプライアンスについては非常に感度が上がっており、専任の担当者をアサインして、問題が起きていないか定常的に評判をモニターしておくべきである。また、MLOpsで開発・運用を進める上では、モデルとフィードバックのループのさらに上位にヒューマン・イン・ザ・ループを作り、人間の目を入れて、不適切なバイアスが反映されていないかといったチェックをしていく必要があるだろう。

コンピテンシーに関するリスクを軽減するためには、現場やIT部門だけで物事を進めるのではなく、事業部門の役員などにスポンサーになってもらい、後ろ盾のもとで開発を進めることがポイントになる。

【次ページ】価値を創る「人」への投資方法、AIは構築すべき?購入すべき?API?

AI・生成AIのおすすめコンテンツ

AI・生成AIの関連コンテンツ

PR

PR

PR