- 会員限定

- 2025/05/22 掲載

【10分完全攻略】AI規制をわかりやすく解説:日本・EU・主要6カ国の“注意点”とは

PwCコンサルティング入社以前は、法律事務所にて日系製造、医療、電力など企業に対し国際取引、海外進出スキームの構築、M&A、エンターテインメント、コンプライアンスなど企業法務に従事。 現在PwCコンサルティングにて、サイバーセキュリティおよびプライバシー保護に関する支援業務に特化。グローバル各国のサイバーセキュリティ、プライバシー、IoTセキュリティ関連法令の調査と対応支援などを担当。

AI規制の現状と背景

AI技術はビジネスのさまざまな分野で広く活用され、企業の成長に寄与する一方で、個人情報の漏えい、偏見、意思決定の透明性の欠如、倫理問題などリスクと課題をもたらしています。そのため、各国はAIに特化した包括的な規制を制定し始めています。現状では、最も厳しい「欧州AI法」、それに続いてAI産業促進を主として成立した「韓国AI基本法」、主に既存法規制で対応する米国、欧州同等に厳しい規制内容である「包括的AI規制」を制定した中国、ブラジル、そしてAI規制と技術革新の両立を目指すことを基本とする日本などがあり、今後もこうした動きは増え続ける見込みです。

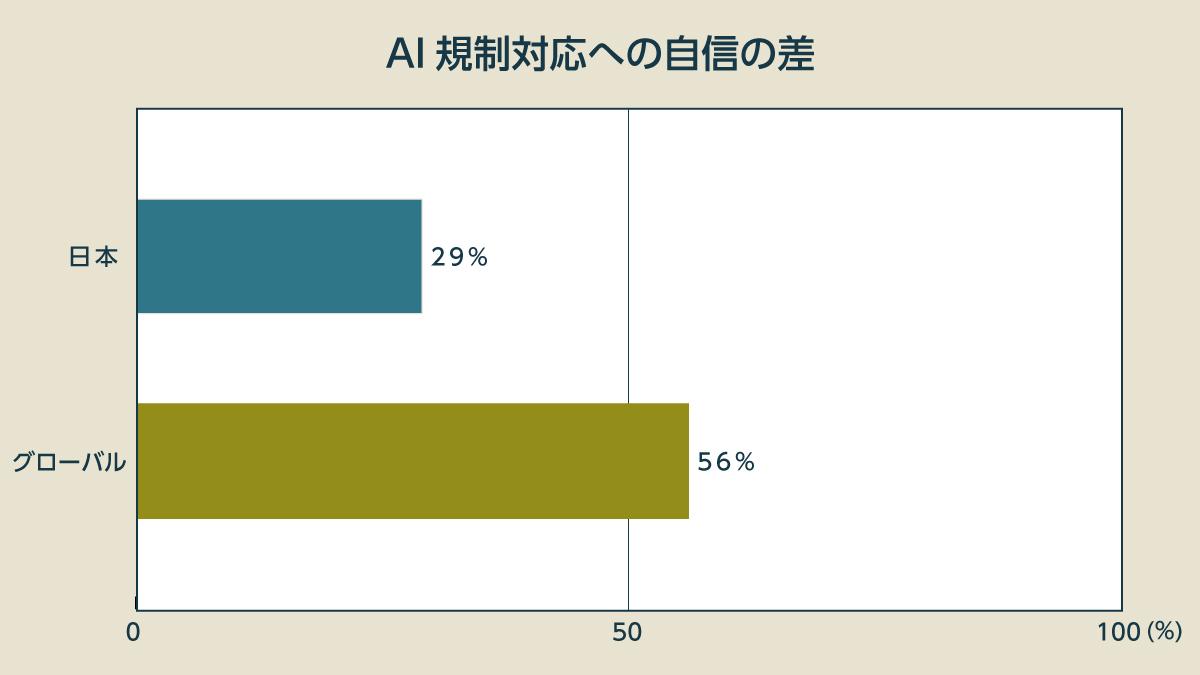

各国の規制内容にはばらつきがみられ、企業はそのコンプライアンス対応に苦慮しています。

これらの法令は部分的には異なる特徴がありますが、AI規制準拠のための制度的ガードレールを構築している点は類似しています。また、各国は既存法令による規制を強化しています。そのため、AIの利活用などにおける違反行為は、適用される法令によってペナルティーが高額化する傾向にあります。

また、製品面でも、AIシステムに使用するデータ(事前)、AIシステムの処理過程(事中)、AIシステムのアウトプット(事後)など、AIシステム利活用の全ライフサイクルにおいて、透明性、説明責任、差別禁止、個人情報保護、著作権保護、製造物責任などさまざまな既存法令の適用が考えられます。

したがって、AI規制コンプライアンス対応は、AIに特化した包括的な規制への準拠のみでは十分と言えず、AIシステムに関係する法令を幅広く調査し、対応を検討する必要があります。

ここからは、欧州、米国、中国など主要国のAI規制を中心に、多層的で複雑なAI規制への準拠について、グローバルに事業を展開する企業は何をすべきかを解説します。そして、日本のAI規制動向についても解説します。

【EU】「欧州AI法」とは?概要・特徴・注意点を解説

欧州AI法は、2024年5月21日に成立し、8月1日に発効しました。今後、規制内容に応じて2030年12月31日までに段階的に施行されていきます。リスクベースのアプローチが採用され、AIをリスクの程度で分類し、その程度に応じた規制が適用されます。欧州AI法は、生成AIを含む世界初の包括的なAI規制です。ペナルティー金額が最高3,500万ユーロ(執筆時点の為替レートで55億円強)または全世界売上高の7%のいずれか高い方と、非常に厳しい罰則を設けています。

欧州AI法は、EU域内で上市されるAIシステムおよび汎用目的型AIモデルと関連するステークホルダーを規制対象としています。適用対象は欧州においてAIシステムを提供、販売、展開するプロバイダー、デプロイヤー、インポーター、ディストリビューターで、サプライチェーン上の関わり方に応じて規制されます。

欧州においてAIシステムのアウトプットが使われる場合など、関わり方により欧州域外の事業者も適用対象となる点に特に注意が必要です。

欧州AI法は、リスクに応じて主に「3つのAI」について規制しています。

1つ目が人命や基本的人権に侵害をもたらす可能性の高い「許容できないリスクを伴う行為」に該当し、活用が禁止されるAI。2つ目がAI法上の要件を満たせば利活用可能な「ハイリスクAI」。最後が透明性・情報提供など、一部の要件を課される「限定リスクの特定用途AI」です。

許容できないリスクは、禁止されるAIシステムとして語られることが多いですが、ハイリスクAIや限定リスクの特定用途AIと異なり、主にAI技術を悪用する行為に対する禁止となります。

これは、欧州委員会が欧州AI法案を検討するに先立って、2019年4月に「AIに関するハイレベルの専門家グループ(AI HLEG)」が策定した「信頼できるAIのための倫理ガイドライン(Ethics guidelines for trustworthy AI)」の3原則とも一貫性を有しています。

- 適用されるすべての法律と規制を尊重

- 倫理原則と価値観の尊重

- 技術的、社会環境の両方を考慮した堅牢性

欧州AI法は、この倫理ガイドラインの3原則への違反行為を禁止されるAI行為として「人の意識に対する意図的操作行為」「弱者に対する搾取行為」、社会的スコアリングとして「一般的な利用行為」「顔認証データの無差別な収集と利用行為」「人の生体認証データからその思想信条などを推測する行為」など具体化しています。

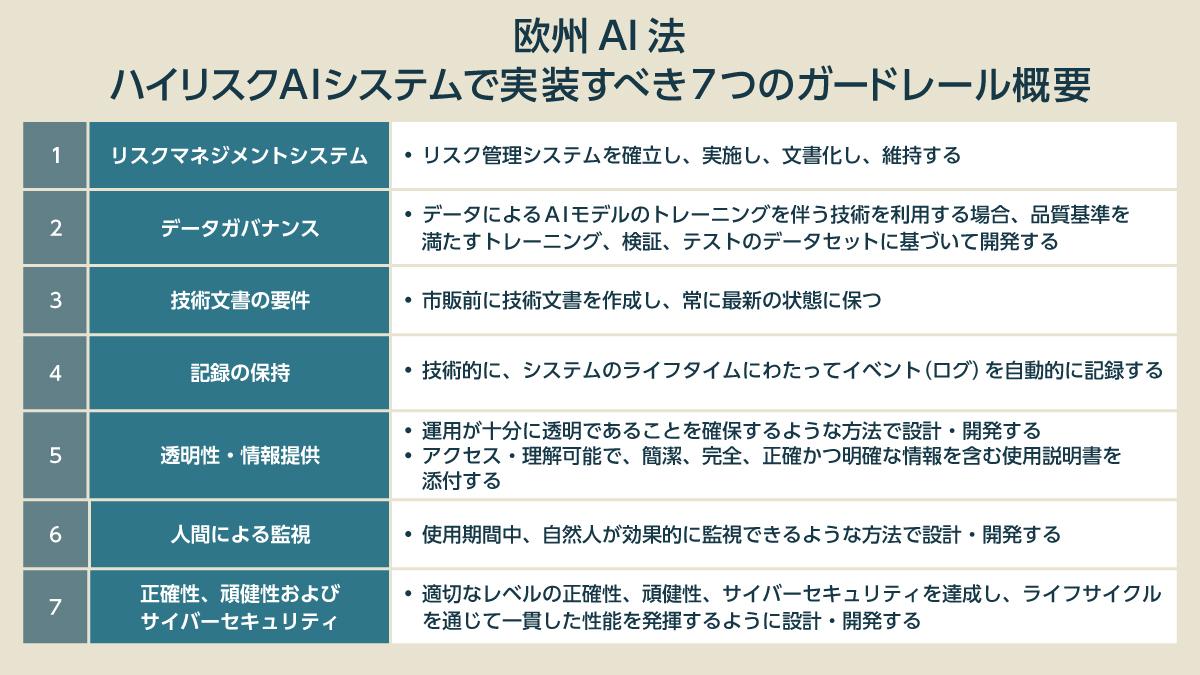

一方、ハイリスクAIに対しては詳細な規制を設けています。ハイリスクAIは、許容できないリスクを冒さないように利活用する必要があり、欧州AI法は新たに包括的な共通の法的要件を課することで実装すべきガードレールを提供しています。

具体的には、上記の「信頼できるAIのための倫理ガイドライン」における7つの要件と評価要求を以下のとおり法制化しています。

ハイリスクAIには、主に2種類のAIシステムが含まれています。

1つは、欧州AI法「付属書Ⅰ」で規定される医療機器、玩具、機械など既存規制の対象となる特定製品が使用する安全コンポーネントにおけるAIシステムです。これらの製品における安全コンポーネントは人の健康と安全に深く関わるからだと考えられます。

もう1つは、欧州AI法が「付属書Ⅲ」で列挙する自然人の感情認識、重要インフラの管理と運用、教育職業訓練、雇用関連などの分野に活用されるAIシステムになります。これらの分野におけるAIシステムは、その使用方法により許容できないリスクを冒しやすいからだと考えられます。

ハイリスクAIについて、その開発者の主な義務は、AIシステムの要件や品質などの技術面と、CEマーク貼付や登録など制度面において欧州AI法に適合することとし、導入者/利用者への要求事項は、権利侵害を防ぐための人間による監視、個人情報保護のためのデータ保護影響評価、データガバナンスなどとなっています。

生成AIなどの汎用AIモデルについては、人の権利や安全に大きく悪影響を及ぼすなどシステミックリスクがあるため、ハイリスクAIに適用される義務のほか、リスク軽減のために必要となる情報提供、透明性に関する追加要件を課しています。

欧州AI法は、AIの開発、利活用についてガードレール的な制度的フレームワークを提供するに過ぎません。

2025年2月4日に、欧州委員会は欧州AI法において禁止されるAI利活用行為に関する拘束力のないガイドラインを公表し、当局としての法解釈観点を示しました。禁止されるAI利活用行為に該当するかという問題は、おおむね既存法の解釈に大きく依拠する内容になっています。

当該ガイドラインが示すように、欧州AI法は、欧州デジタル法体系全体の中で理解する必要があります。

たとえば、AIシステムに取り込むデータ、とりわけ個人情報の保護は欧州の一般データ保護規制(GDPR)によって規制され、違反した場合のペナルティーは非常に高額になっています。また、欧州の改正製造物責任指令(PL指令)は、AIシステムを規制対象として追加しており、欠陥あるAIシステムは消費者による訴訟の対象となる可能性があります。さらに、AIシステムは製品セキュリティ規制としての欧州サイバーレジリエンス法上のサイバーセキュリティ要件を満たすことが求められます。

したがって、欧州AI法対応は関連する複数の法令への複合的な対応が必要となります。 【次ページ】【米国】AI規制の現状:法はないが大統領令と州ごとの規制

AI・生成AIのおすすめコンテンツ

AI・生成AIの関連コンテンツ

PR

PR

PR