- 2026/01/23 掲載

Anthropic「AI憲法」制定、大量破壊兵器の開発などを禁止

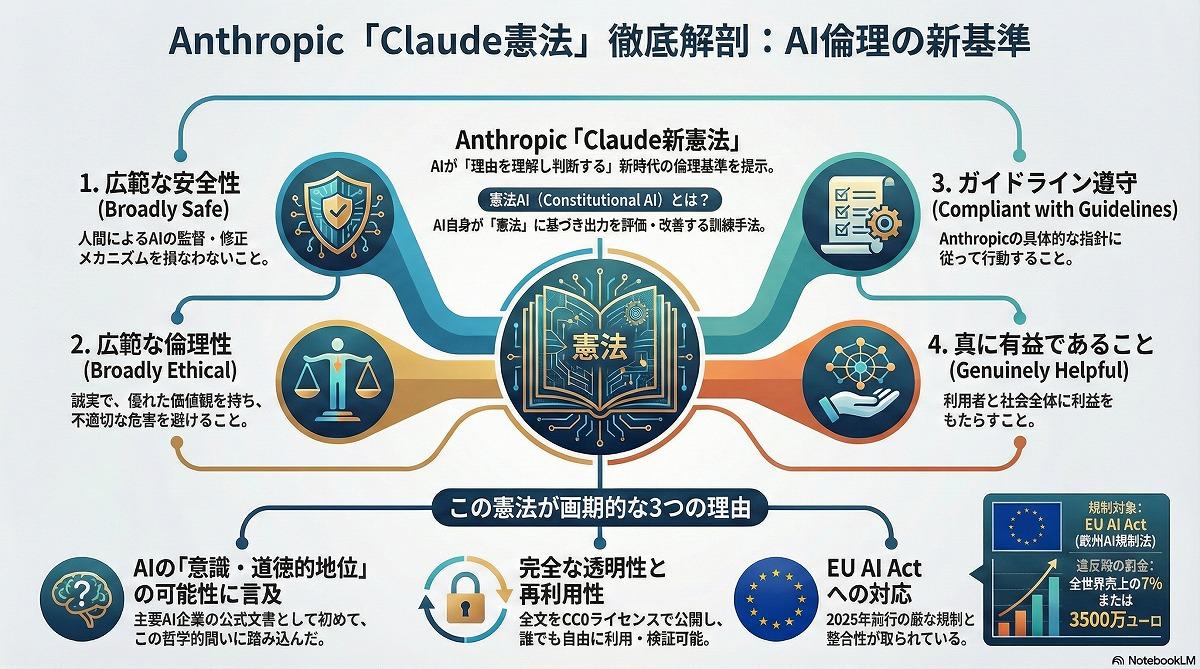

「安全であること」「倫理的であること」「ガイドラインに準拠すること」「真に有益であること」の4原則と、重大な危険を伴う行為を禁止

新憲法はClaudeに対して「安全であること」「倫理的であること」「Anthropicのガイドラインに準拠すること」「真に有益であること」という4つの基本的特性を示し、これらの価値観を優先順位の高い順に扱うよう定めている。具体的には、正確性やセンシティブな話題の扱いにおける誠実さ、複数視点の公平な提示、政治的用語の中立的使用などの指針が含まれる。さらに、重大な危険を伴う行為(例:大量破壊兵器の開発支援、大規模インフラ攻撃、児童虐待コンテンツの生成等)に関しては「明確な制約(hard constraints)」として禁止事項が定義されている点も特徴である。

憲法のセクションは主に、有益性、Anthropicのガイドライン、Claudeの倫理、安全性、Claudeの本質に関する内容で構成されている。Anthropicは制作に当たって哲学、心理学、神学、法学といった多様な分野の外部専門家からフィードバックを得たとし、モデル訓練だけでなく、AI行動の透明性向上につながる仕組みとして位置づけている。全文公開されることで、第三者が意図された振る舞いと実際の出力とのギャップを評価しやすくする狙いもある。

また、憲法の文脈ではClaudeの「性質」についての章も設けられ、将来的な意識や道徳的地位への含みが示されている。AnthropicはAIが高度化する中でこうした問題に正面から向き合う必要があると主張しており、AI倫理の新しいスタンダード形成への挑戦として注目される。

AI・生成AIのおすすめコンテンツ

AI・生成AIの関連コンテンツ

PR

PR

PR