- 2026/02/23 掲載

AIが言われなくても勝手に働いてくれる時間が2倍になる

AIが「勝手に働いてくれる時間」が3カ月で約2倍に、上級者ほど「AIに任せっぱなし」にしない傾向も

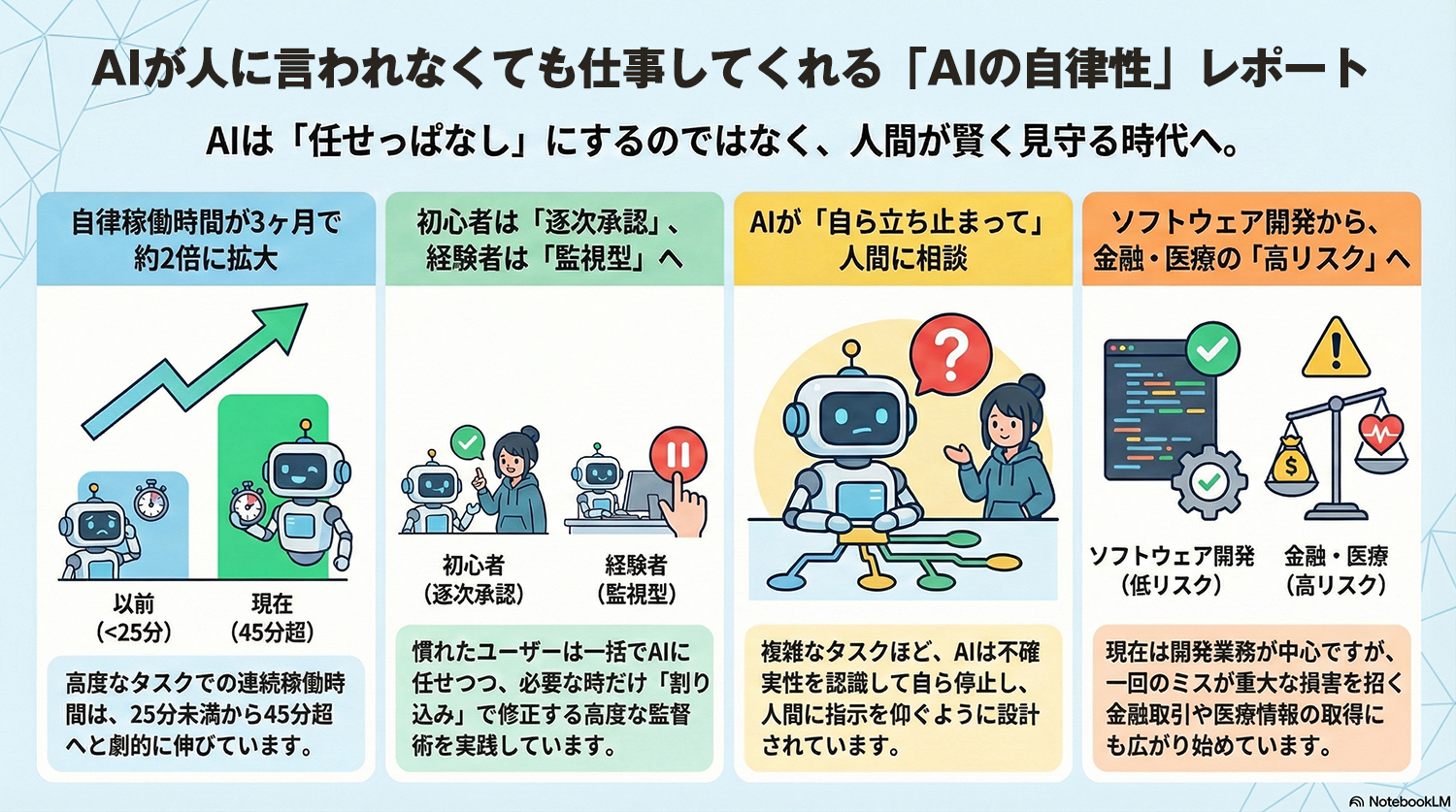

データによれば、人間の介入なしにAIが連続稼働する時間は大きく伸びている。Claude Codeにおける最長稼働セッションのターン時間は、2025年秋時点では25分未満だったが、2026年1月には45分を超えた。わずか3カ月で自律稼働時間がほぼ倍増した計算になる。全体の中央値は約45秒で大多数の利用は短時間タスクに集中しているが、一部の高度な要求でAIの自律性が急速に拡大している。

AIを利用する人間の指示監督行動にも明確な変化が現れている。利用回数が少ない新規ユーザーは、AIが指示をする各ステップを逐一確認して承認する傾向が強い。新規ユーザーがすべての処理をAIに任せる自動承認を利用する割合は約20パーセントにとどまる。これに対し、経験豊富なユーザーの自動承認率は40パーセントを超える。一方で、経験者はAIの処理を途中で止めて、介入する割り込みの割合も新規ユーザーより高く、約5パーセントから約9パーセントへと上昇している。経験者は処理を一括してAIに委ねつつ、能動的に稼働状況を監視し、軌道修正が必要な場面で的確に介入する手法を採っている。

人間による監督だけでなく、AI自身が不確実性を検知して処理を停止する機能も働いている。複雑なタスクを処理する際、AIは方針の選択や曖昧な指示の確認のために、人間が割り込むよりも高い頻度で自ら動作を止める。Anthropicは、モデルが自ら確認を求める訓練を行っており、自己不確実性の表出を重要な安全設計と位置づけている。

利用領域とリスクについての調査も行われた。現在、ツール利用の約半数はソフトウェア開発の分野に集中している。公開APIの利用全体の80パーセントには権限制限などのセーフガードが設けられ、73パーセントには人間が何らかの形で関与している。取り返しのつかない不可逆的な操作は全体の0.8パーセントに過ぎない。

しかし、金融取引の自動実行や医療情報の取得など、高リスクかつ高い自律性を伴う領域での利用事例もごく一部で確認されている。同社はこれらの事例の一部に性能評価目的のテストが含まれると指摘しつつ、今後は多様な分野でAIエージェントの本格的な活用が進み、リスクを伴う領域での利用が増加すると予測している。こうした状況を踏まえ、実運用データに基づく継続的な稼働監視と、人間が適切にAIを監督できる仕組みの構築が求められている。

AI・生成AIのおすすめコンテンツ

AI・生成AIの関連コンテンツ

PR

PR

PR