- 2026/01/20 掲載

元OpenAIポリシー責任者、AI安全監査団体 AVERI 設立、外部監査でAI安全性の標準化

家電製品の安全認証のような評価体制をAI分野に導入するため4段階の監査保証レベルを提唱

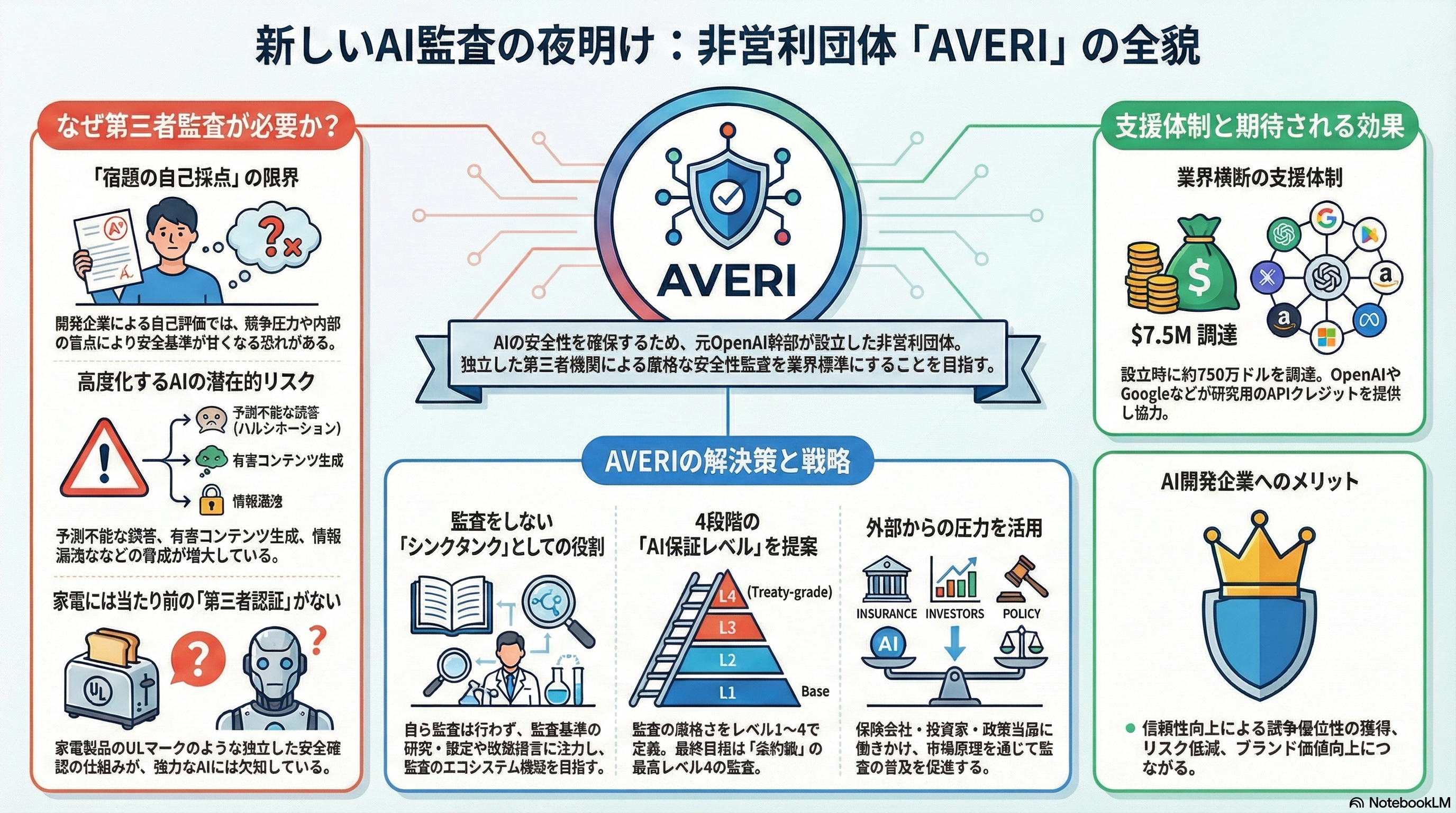

AVERIは先端AIシステムの安全性・セキュリティに関する第三者評価と監査の実施を訴える組織で、AI企業自身が自らの安全対策を評価する「自己採点」ではなく、中立的な外部監査を行う仕組みを推進する。AVERIは独自の監査フレームワーク(AI Assurance Levels)を提案しており、AIシステムとその開発プロセスが一定水準の安全・信頼性基準を満たしているかを第三者が検証する仕組みの標準化を目指す。

AVERIのビジョンの1つは、家庭用電気製品の安全認証制度のように、AIシステムも独立した機関による評価を受けることを業界標準とすることだ。これは、家電製品で一般的な第三者安全試験(例:ULやPSEマーク)に例えられ、消費者や社会の信頼を高めることが期待されている。AI企業による自主的な発表情報だけではなく、客観的データと評価を基に安全性を保証する仕組み構築がAVERIの中心的な目的だ。

AVERIは単に監査を実行する団体ではなく、研究・標準策定・政策提言活動を通じて、AI安全の第三者監査が広く受け入れられる環境の整備を目指している。またAVERIの設立には30人以上の専門家が関与しており、AIガバナンスや安全性評価に関する専門知見集積と標準化への取り組みが進められている。

この動きは、AI開発の加速とともにAIモデルの社会的リスクや安全性への関心が高まるなか、独立した評価基盤の必要性が強まっている点を背景としている。AVERIが提示する評価フレームワークは、AI企業や規制当局、ユーザー側双方にとって透明性の高い安全評価手法を提供することを狙いとしている。

AI・生成AIのおすすめコンテンツ

関連リンク

AI・生成AIの関連コンテンツ

PR

PR

PR