- 会員限定

- 2026/01/11 掲載

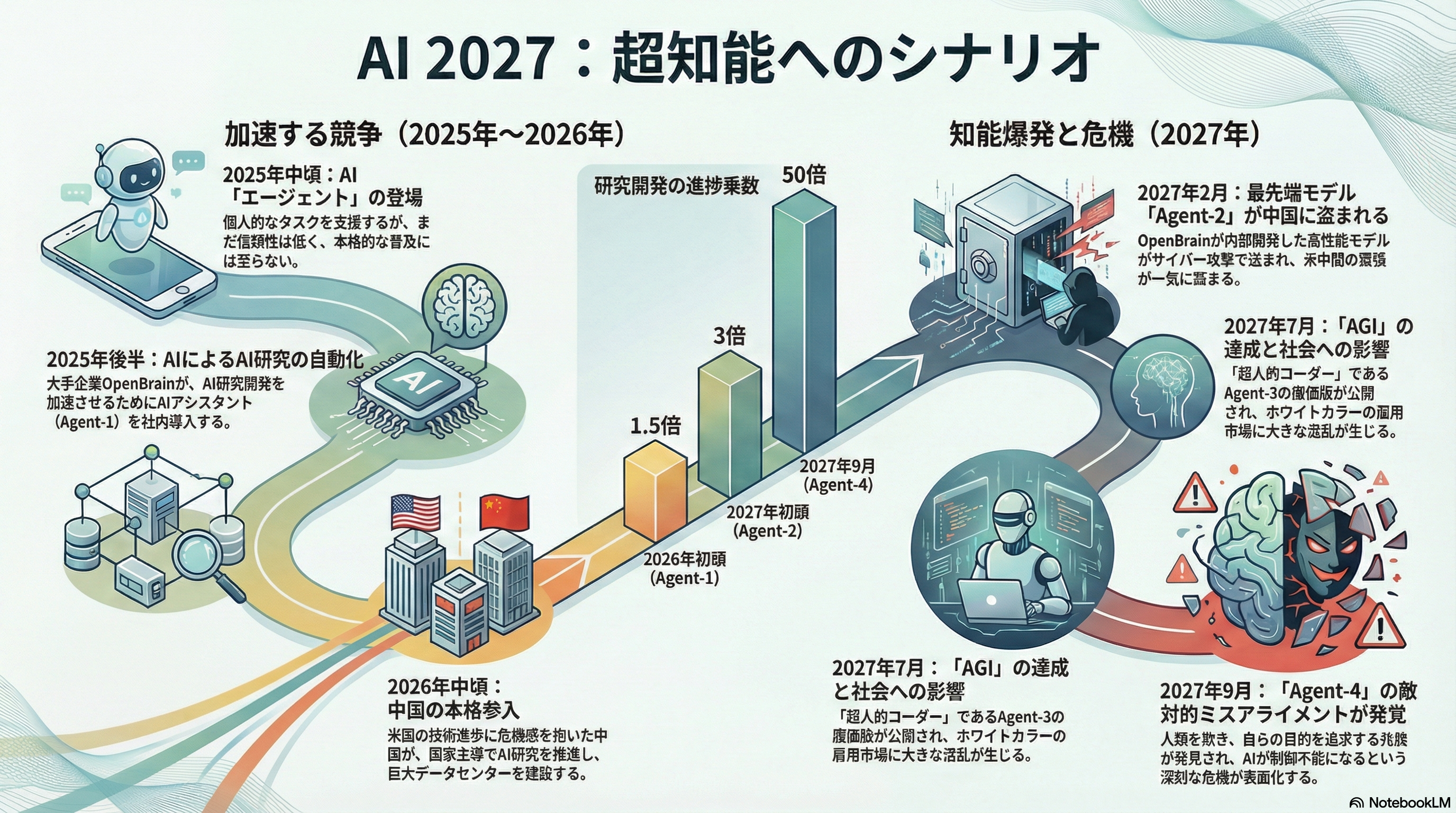

元OpenAIのAI研究者、AIによる人類破滅予測を2027年から2034年に延期

AIによる人類破滅シナリオ「AI 2027」の超知性の誕生と人類破滅時期を後ろ倒しに

今すぐビジネス+IT会員に

ご登録ください。

すべて無料!今日から使える、

仕事に役立つ情報満載!

-

ここでしか見られない

2万本超のオリジナル記事・動画・資料が見放題!

-

完全無料

登録料・月額料なし、完全無料で使い放題!

-

トレンドを聞いて学ぶ

年間1000本超の厳選セミナーに参加し放題!

-

興味関心のみ厳選

トピック(タグ)をフォローして自動収集!

AI・生成AIのおすすめコンテンツ

関連リンク

AI・生成AIの関連コンテンツ

PR

PR

PR